6 生物学基础知识{#biology}

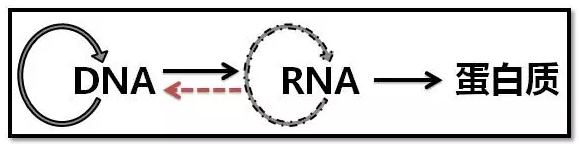

6.1 中心法则

中心法则是指遗传信息经过DNA转录成信使RNA(mRNA),再由转运RNA(tRNA)和核糖体将mRNA翻译成蛋白质(Protein),完成遗传信息经DNA—RNA—蛋白质的传递。 也可以由DNA自我复制成DNA,即完成遗传信息由DNA—DNA的传递。 这是所有具有细胞结构的生物所遵循的法则。另外在某些病毒中的RNA自我复制和在某些病毒中以RNA为模版逆转录成DNA的过程,是对中心法则的补充。

6.1.1 DNA 与 复制

脱氧核糖核酸又称去氧核糖核酸,是一种生物大分子,可组成遗传指令,引导生物发育与生命机能运作。主要功能是信息储存,可比喻为“蓝图”或“食谱”。其中包含的指令,是建构细胞内其他的化合物,如蛋白质与核糖核酸所需。带有蛋白质编码的DNA片段称为基因。脱氧核糖核酸又称去氧核糖核酸,是一种生物大分子,可组成遗传指令,引导生物发育与生命机能运作。主要功能是信息储存,可比喻为“蓝图”或“食谱”。其中包含的指令,是建构细胞内其他的化合物,如蛋白质与核糖核酸所需。带有蛋白质编码的DNA片段称为基因。

DNA是一种长链聚合物,组成单位为四种脱氧核苷酸,即: 腺嘌呤脱氧核苷酸(dAMP )、胸腺嘧啶脱氧核苷酸(dTMP )、胞嘧啶脱氧核苷酸(dCMP )、鸟嘌呤脱氧核苷酸(dGMP )。

而脱氧核糖(五碳糖)与磷酸分子借由酯键相连,组成其长链骨架,排列在外侧,四种碱基排列在内侧。每个糖分子都与四种碱基里的其中一种相连,这些碱基沿着DNA长链所排列而成的序列,可组成遗传密码,指导蛋白质的合成。读取密码的过程称为转录,是以DNA双链中的一条单链为模板转录出一段称为mRNA(信使RNA)的核酸分子。多数RNA带有合成蛋白质的讯息,另有一些本身就拥有特殊功能,例如rRNA、snRNA与siRNA。

在细胞内,DNA能与蛋白质结合形成染色体,整组染色体则统称为染色体组。对于人类而言,正常的人体细胞中含有46条染色体。染色体在细胞分裂之前会先在分裂间期完成复制,细胞分裂间期又可划分为:G1期-DNA合成前期、S期-DNA合成期、G2-DNA合成后期。对于真核生物,如动物、植物及真菌而言,染色体主要存在于细胞核内;而对于原核生物,如细菌而言,则主要存在于细胞质中的拟核内。染色体上的染色质蛋白,如组织蛋白,能够将DNA进行组织并压缩,以帮助DNA与其他蛋白质进行交互作用,进而调节基因的转录。

DNA是高分子聚合物,DNA溶液为高分子溶液,具有很高的粘度,可被甲基绿染成绿色。DNA对紫外线(260nm)有吸收作用,利用这一特性,可以对DNA进行含量测定。当核酸变性时,吸光度升高,称为增色效应;当变性核酸重新复性时,吸光度又会恢复到原来的水平。较高温度、有机溶剂、酸碱试剂、尿素、酰胺等都可以引起DNA分子变性,即DNA双链碱基间的氢键断裂,双螺旋结构解开—也称为DNA的解螺旋。

6.1.2 RNA 与 转录

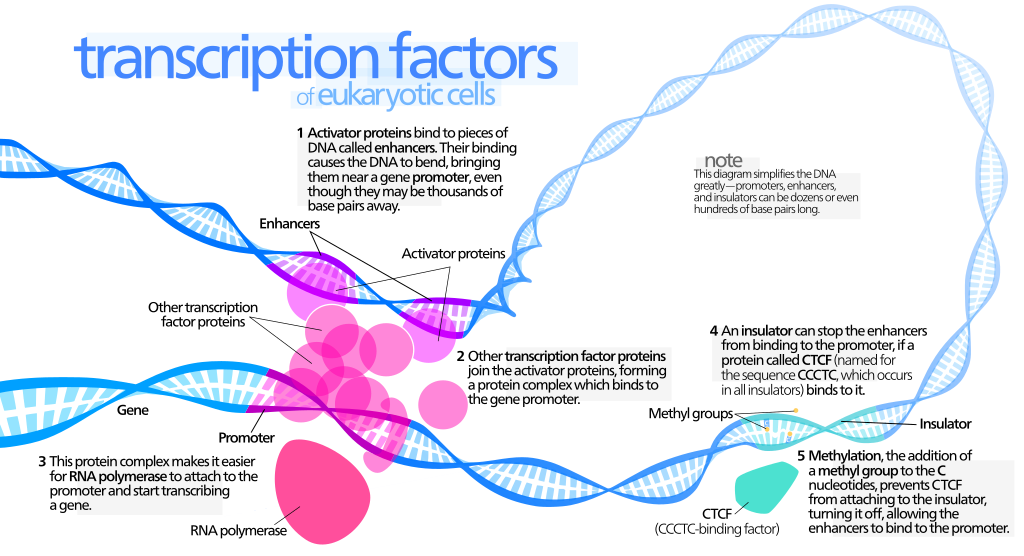

转录(Transcription)是遗传信息由DNA转换到RNA的过程,即信使RNA(mRNA)以及非编码RNA(tRNA、rRNA等)的合成步骤。转录中,一个基因会被读取、复制为mRNA;这个过程由RNA聚合酶(RNA polymerase)和转录因子(transcription factor)所共同完成。

两个真核生物转录必备基础名词: - 顺式调控元件,Cis-regulatory elements (CREs) :增强或抑制其附近基因转录活性的非编码区域。通常是转录因子结合位点(TFBS): promoter, enhancers, silencers, and insulators. - 反式作用因子:能够特异结合顺式作用元件的因子,多数为蛋白质,如RNA聚合酶,能和RNA聚合酶结合稳定转录起始复合物的蛋白质等。

1. 转录和转录调控

转录组即某个物种或特定细胞在某一功能状态下产生的所有RNA的总和,可以揭示基因组序列中哪些序列能够表达,而且还能揭示在何时何处表达,以及转录活跃程度。

在每个细胞中,只有一部分基因是能够转录,此处染色质多为开放状态,其余的基因则处于抑制状态,对应的染色质状态较为紧密。在细胞中,保持一类基因的关闭,而另一类基因开启的状态称为基因调控,基因调控是动态的,在生物生长发育中起重要作用。基因表达的调控包含诸多维度比如信号转导,转录前(包括染色质构象和表观调控等),转录调控,转录后调控(剪切、编辑、转运等等),翻译和翻译后调控。其中多个步骤都是围绕着基因序列(DNA序列—传统的认为是顺式元件Cis)和其结合因子包括蛋白和非蛋白因子(传统地认为反式作用因子Trans)而发生。wiki中给出了转录因子可能参与转录调控的所有途径,见下图:

基因的表观和转录调控可以分为两个层面,顺式元件和反式因子,技术方法学也可以简单粗暴地分为以研究顺式元件或反式因子为主的两类方法学:

已知或候选反式因子(表观和转录因子)和顺式元件的研究手段较成熟,比如经典的EMSA,报告基因,ChIP等。

如何研究在native状态下与之相互作用的未知反式因子? 基因组非编码区域含有大量的组织特异性的调控序列,包括基因转录增强子(enhancer)、沉默子(silencer)、绝缘子(insulators) 等。这些调控序列通常结合几个,几十个,甚至几百个调控因子(包括转录因子,染色质调控蛋白,组蛋白,RNA分子)以及他们形成的三维结构。用来分离纯化单个调控序列的传统的方法面临的最大的挑战是无法区分结合调控序列的特异性调控因子和细胞内大量的非特异性因子。现有的技术包括locked nucleic acids (LNAs)和transcription activator-like (TAL)蛋白只能用在分离纯化多拷贝的基因组重复序列,比如染色体端粒(telomere)。而其他的常规技术,比如ChIP-seq和ChIA-PE则依赖于单个调控因子或组蛋白修饰,而并不能纯化和分析单个调控序列所结合的多个调控因子以及三维结构。在今年8月刚被cell报道的In Situ capture of chromatin interactions by biotinylated dCAS9中,作者首次利用了“biotinylated dCAS9”的方法建立了高分辨率,位点特异原位DNA-蛋白质以及其他元件的互作网络,为攻克这一难题揭开了序幕 [^ref1]。

2. 转录与NGS

转录组测序的分析流程大致可以分成三类,包括基因组比对(Genome mapping)、转录组比对(Transcriptome mapping)、转录组组装(Reference-free assembly。其中第三种主要是用于分析没有参考基因组和基因注释的物种,应用场合较少且不适合新手入门。对于人、小鼠、大鼠等模式物种,通常用前两种方法进行分析。

转录组测序一般是在你有了一部分生理生化的实验结果,如表型差异、生理指标发生明显变化或有效物质含量出现明显差异等等,在这个基础上你可能会问自己,这些现象内在的机制如何。所以,转录组测序核心回答的是那些基因组存在表达差异,这些存在差异的基因都涉及什么功能,是如何发挥作用的。可以根据实验的目的确定需要转录组测序还是表达谱测序。

转录组测序和表达谱测序的区别

- 转录组测序 RNA-seq(Transcriptome)

- 定义: 通过RNA测序,既想得到样本中序列的信息,又需要对序列的表达进行定量和分析。

- 没有参考基因组的物种,RNA-seq (Transcriptome) 需要进行de novo拼接,对拼接得到的Unigene进行注释; 然后计算de novo得到的Unigene的表达量。所以,这个分析就包含了核酸序列分析和核酸表达定量分析。

- 对于已有参考基因组的物种,RNA-seq (Transcriptome) 会对测序结果进行基于参考基因组的比对和拼接,从而分析样本中转录本的可变剪切、基因融合、SNP变异等此类针对转录本序列的分析;在序列分析的基础上,在分析转录本的表达量。所以,这个分析也包含了核酸序列的分析和核酸表达量的分析。

- 对测序的要求:因为涉及到序列的拼接和组装,所以转录组测序对数据量的要求较高(一般单个样本的测序量> 4G),同时一般要求使用双末端测序(Paired end)的数据。

- 定义: 通过RNA测序,既想得到样本中序列的信息,又需要对序列的表达进行定量和分析。

- 表达谱测序 RNA-seq(Qualification)

- 定义:Qualification,顾名思义,这个产品的定义就是只对样本中mRNA进行定量分析,而不需要分析mRNA序列的变化。通常此类分析,需要参考序列。参考序列可以是:基因组序列(有参考基因组的物种)或转录组序列(无参考基因组物种,转录组de novo拼接的结果)。

- 对此类产品的分析要求仅仅是:将测序得到的数据比对到参考序列上,然后计算参考序列的在样本中的对应表达,而不需要去分析参考序列在样本中是否发生了序列变化(可变剪切、基因融合、SNP等)。一般单个样本的测序量2~3G足够,同时单末端测序(single End)和双末端测序(paired End)的数据均可以分析。

3. 转录调控与NGS

常用的转录调控测量技术

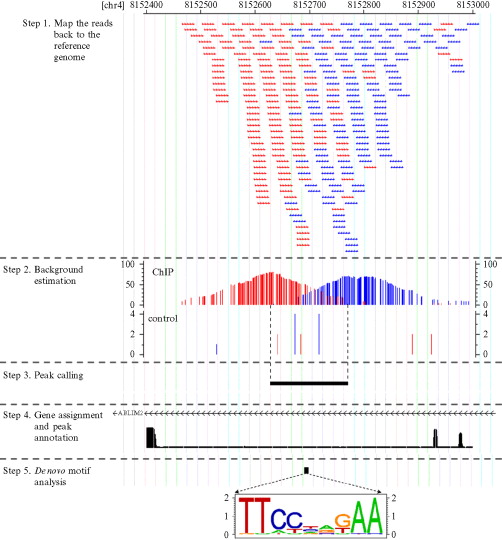

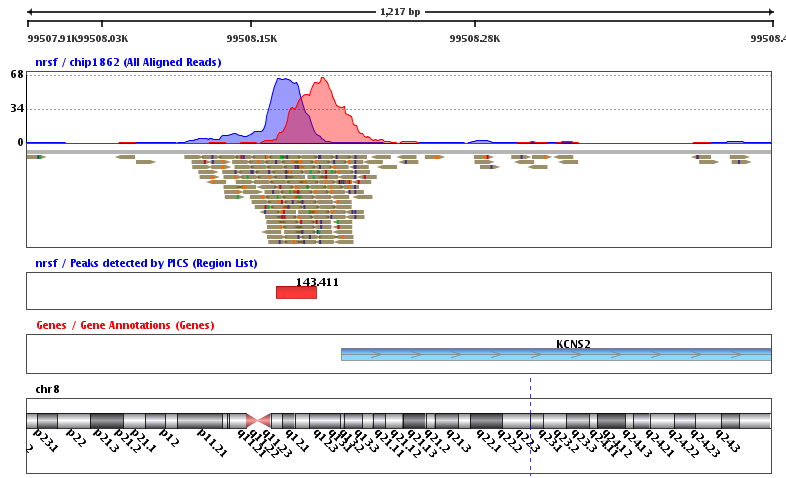

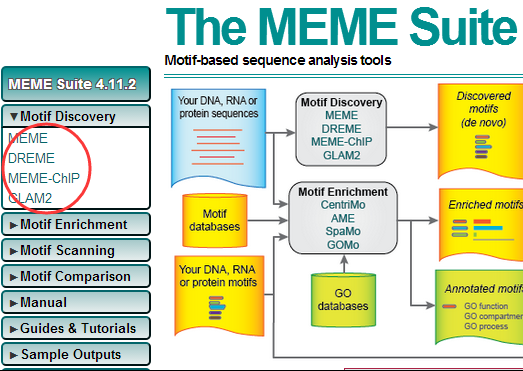

参考上文提及的转录因子的调控路径,2012 Shirley Liu 的Minireview: Applications of Next-Generation Sequencing on Studies of Nuclear Receptor Regulation and Function 总结得很好,主要有Gene Expression Profiling, Transcription Factor Cistrome Mapping, Epigenome Profiling, Interactions in Three Dimensions, 也直接上图表示:

(Next-generation sequencing applications in studies of transcriptional regulation. Applications in red make use mainly of the quantification of abundance, whereas applications in blue make use of sequence-based observations.)

NGS分析手段

对于可以直接参考HOMER提供的教程,学会了就能分析ChIP-Seq, GRO-Seq, RNA-Seq, DNase-Seq, Hi-C and numerous other types of functional genomics sequencing data sets。 入门应不成问题,官网在此http://homer.ucsd.edu/homer。

总结

转录是在DNA和蛋白质之间传递信息的关键,调控途径多样,分析手段因此也层出不穷,多结合生物学背景,多看文献,才能想到idea再找数据去分析,光会用却不明白相关关系还是不行的。

6.1.3 protein

6.1.4 其它

6.2 组学

介绍常见的6种组学技术,有待完善

6.2.1 基因组

基因组学是一个非常广的概念,研究的可以是全基因组的重测序,比如对人类来说,基因组大小是3G(30亿个碱基),我的全基因组测序共8.9亿条150bp的reads,那么全基因组范围的平均测序深度就是8.9亿*150/30亿~45X。

当然并不是每个实验对象都需要测多达10亿条reads,可以只选择基因组上面的编码基因的外显子设计好特异性的探针后捕获它们进行集中测序,这个就是外显子测序。外显子测序一般测几千万条reads就可以了,虽然测序总量只有全基因组测序的1%,但是外显子区域(30M)也只有全基因组(3G)的1%,所以测序深度仍然可以达到50X以上,足以做大部分的数据分析。

即使是只测全外显子,单个样本的数据量的确不大,但是要推广到千千万万的实验样本,这个累积数据量就可观了,同时分析速度也是一个限制,而且所有的外显子包含的信息量也太多,并不是每一个人都需要。这个时候有针对性的靶向捕获测序就显示出它的优点了。可以是针对十几个基因,或者几百个有明确意义(一般是疾病等性状相关)的基因panel。当然,捕获测序的最终目标也是找到跟参考基因组不一致的位点,来解释为什么这个样本有这样的变异。

如果是癌症研究,那么测序策略也会稍有不同,上面提到的全基因组,全外显子组,靶向测序都可以应用到癌症研究。但是癌症研究有个特色,就是对每个个体不只是要测癌症部位的DNA信息,还需要提取该个体的正常组织进行对照。去除那些个体特异性的变异位点,或者那些没有太大的临床表型意义的germline mutation位点。

最后,值得一提的是,上面的分析都是建立在测序个体的物种参考基因组是已知的前提,所以只需要跟参考基因组进行比较,来找差异。但即使是在测序数据已经海量的今天,也不是每个物种都有了参考基因组,这个时候基因组的de novo测序就可以大展身手了。它的分析流程也完全不一样。

6.2.1.1 全基因组重测序分析流程分享

这里选取的是GATK best practice 是目前认可度最高的全基因组重测序分析流程,尤其适用于

人类研究。

流程介绍

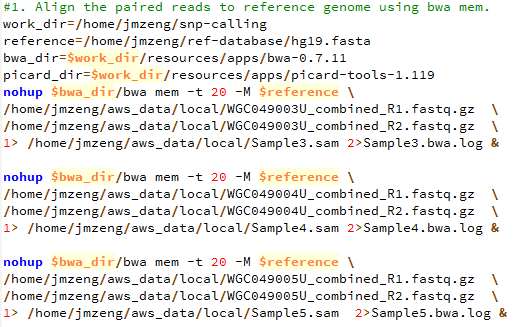

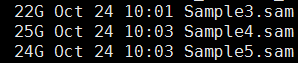

- bwa(MEM alignment)

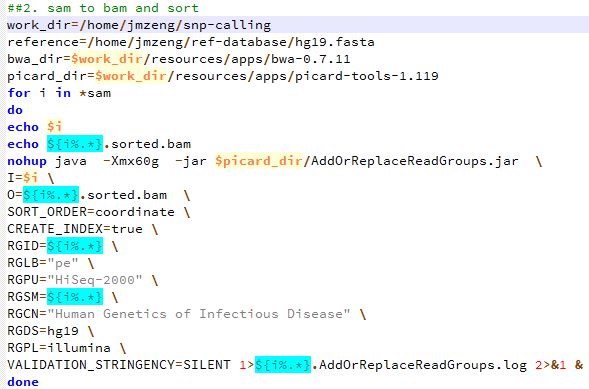

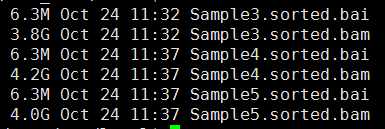

- picard(SortSam)

- picard(MarkDuplicates)

- picard(FixMateInfo)

- GATK(RealignerTargetCreator)

- GATK(IndelRealigner)

- GATK(BaseRecalibrator)

- GATK(PrintReads)

- GATK(HaplotypeCaller)

- GATK(GenotypeGVCFs)

在本文,我将会把我的全基因组重测序数据走完上面所有的流程,并给出代码和时间消耗情况。

准备工作

首先是软件安装

## Download and install BWA

cd ~/biosoft

mkdir bwa && cd bwa

#http://sourceforge.net/projects/bio-bwa/files/

wget https://sourceforge.net/projects/bio-bwa/files/bwa-0.7.15.tar.bz2

tar xvfj bwa-0.7.15.tar.bz2 # x extracts, v is verbose (details of what it is doing), f skips prompting for each individual file, and j tells it to unzip .bz2 files

cd bwa-0.7.15

make

## Download and install samtools

## http://samtools.sourceforge.net/

## http://www.htslib.org/doc/samtools.html

cd ~/biosoft

mkdir samtools && cd samtools

wget https://github.com/samtools/samtools/releases/download/1.3.1/samtools-1.3.1.tar.bz2

tar xvfj samtools-1.3.1.tar.bz2

cd samtools-1.3.1

./configure --prefix=/home/jianmingzeng/biosoft/myBin

make

make install

~/biosoft/myBin/bin/samtools --help

~/biosoft/myBin/bin/plot-bamstats --help

cd htslib-1.3.1

./configure --prefix=/home/jianmingzeng/biosoft/myBin

make

make install

~/biosoft/myBin/bin/tabix

## Download and install picardtools

## https://sourceforge.net/projects/picard/

## https://github.com/broadinstitute/picard

cd ~/biosoft

mkdir picardtools && cd picardtools

wget http://ncu.dl.sourceforge.net/project/picard/picard-tools/1.119/picard-tools-1.119.zip

unzip picard-tools-1.119.zip

mkdir 2.9.2 && cd 2.9.2

wget https://github.com/broadinstitute/picard/releases/download/2.9.2/picard.jar

## GATK 需要自行申请下载,不能公开其次是必备数据的下载

cd ~/reference

mkdir -p genome/human_g1k_v37 && cd genome/human_g1k_v37

# http://ftp.1000genomes.ebi.ac.uk/vol1/ftp/technical/reference/

nohup wget http://ftp.1000genomes.ebi.ac.uk/vol1/ftp/technical/reference/human_g1k_v37.fasta.gz &

gunzip human_g1k_v37.fasta.gz

wget http://ftp.1000genomes.ebi.ac.uk/vol1/ftp/technical/reference/human_g1k_v37.fasta.fai

wget http://ftp.1000genomes.ebi.ac.uk/vol1/ftp/technical/reference/README.human_g1k_v37.fasta.txt

java -jar ~/biosoft/picardtools/picard-tools-1.119/CreateSequenceDictionary.jar R=human_g1k_v37.fasta O=human_g1k_v37.dict

cd ~/reference

mkdir -p index/bwa && cd index/bwa ~/reference/index/bwa/human_g1k_v37 ~/reference/genome/human_g1k_v37/human_g1k_v37.fasta 1>human_g1k_v37.bwa_index.log 2>&1 &

mkdir -p ~/biosoft/GATK/resources/bundle/b37

cd ~/biosoft/GATK/resources/bundle/b37

wget ftp://gsapubftp-anonymous@ftp.broadinstitute.org/bundle/b37/1000G_phase1.indels.b37.vcf.gz

wget ftp://gsapubftp-anonymous@ftp.broadinstitute.org/bundle/b37/1000G_phase1.indels.b37.vcf.idx.gz

wget ftp://gsapubftp-anonymous@ftp.broadinstitute.org/bundle/b37/Mills_and_1000G_gold_standard.indels.b37.vcf.gz

wget ftp://gsapubftp-anonymous@ftp.broadinstitute.org/bundle/b37/Mills_and_1000G_gold_standard.indels.b37.vcf.idx.gz

gunzip 1000G_phase1.indels.b37.vcf.idx.gz

gunzip 1000G_phase1.indels.b37.vcf.gz

gunzip Mills_and_1000G_gold_standard.indels.b37.vcf.gz

gunzip Mills_and_1000G_gold_standard.indels.b37.vcf.idx.gz

mkdir -p ~/annotation/variation/human/dbSNP

cd ~/annotation/variation/human/dbSNP

## https://www.ncbi.nlm.nih.gov/projects/SNP/

## ftp://ftp.ncbi.nih.gov/snp/organisms/human_9606_b147_GRCh38p2/

## ftp://ftp.ncbi.nih.gov/snp/organisms/human_9606_b147_GRCh37p13/

nohup wget ftp://ftp.ncbi.nih.gov/snp/organisms/human_9606_b147_GRCh37p13/VCF/All_20160601.vcf.gz &

wget ftp://ftp.ncbi.nih.gov/snp/organisms/human_9606_b147_GRCh37p13/VCF/All_20160601.vcf.gz.tbi

上述代码都是可以直接在linux/MAC里面运行的,只有当软件安装完毕,还有参考基因组等必备文件准备齐全了,才能正式进入全基因组重测序分析流程!

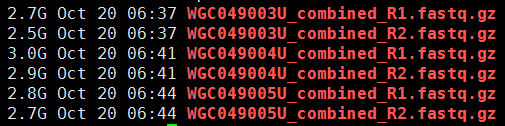

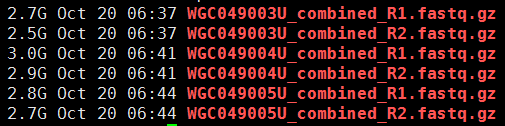

上面是我的全基因组数据fastq文件的截图,测序分成了5条lane,每条lane的数据量不一致。

数据分析

数据分析的主线就是 fastq–>bam–>vcf 这样的数据转换,中间选择不同的工具已经使用不同的参数,所以流程得到的结果会略微不同。这里仅介绍我多年实践的最佳流程,希望对读者有所启发。

首先是fastq2bam步骤

代码

module load java/1.8.0_91

GENOME=/home/jianmingzeng/reference/genome/human_g1k_v37/human_g1k_v37.fasta

INDEX=/home/jianmingzeng/reference/index/bwa/human_g1k_v37

GATK=/home/jianmingzeng/biosoft/GATK/GenomeAnalysisTK.jar

PICARD=/home/jianmingzeng/biosoft/picardtools/2.9.2/picard.jar

DBSNP=/home/jianmingzeng/annotation/variation/human/dbSNP/All_20160601.vcf.gz

SNP=/home/jianmingzeng/biosoft/GATK/resources/bundle/b37/1000G_phase1.snps.high_confidence.b37.vcf.gz

INDEL=/home/jianmingzeng/biosoft/GATK/resources/bundle/b37/Mills_and_1000G_gold_standard.indels.b37.vcf.gz

TMPDIR=/home/jianmingzeng/tmp/software

## samtools and bwa are in the environment

## samtools Version: 1.3.1 (using htslib 1.3.1)

## bwa Version: 0.7.15-r1140

: '

'

## please keep the confige in three columns format, which are fq1 fq2 sampe

cat $1 |while read id

do

arr=($id)

fq1=${arr[0]}

fq2=${arr[1]}

sample=${arr[2]}

#####################################################

################ Step 1 : Alignment #################

#####################################################

echo bwa `date`

bwa mem -t 5 -R "@RG\tID:$sample\tSM:$sample\tLB:WGS\tPL:Illumina" $INDEX $fq1 $fq2 > $sample.sam

echo bwa `date`

#####################################################

################ Step 2: Sort and Index #############

#####################################################

echo SortSam `date`

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $PICARD SortSam SORT_ORDER=coordinate INPUT=$sample.sam OUTPUT=$sample.bam

samtools index $sample.bam

echo SortSam `date`

#####################################################

################ Step 3: Basic Statistics ###########

#####################################################

echo stats `date`

samtools flagstat $sample.bam > ${sample}.alignment.flagstat

samtools stats $sample.bam > ${sample}.alignment.stat

echo plot-bamstats -p ${sample}_QC ${sample}.alignment.stat

echo stats `date`

#####################################################

####### Step 4: multiple filtering for bam files ####

#####################################################

###MarkDuplicates###

echo MarkDuplicates `date`

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $PICARD MarkDuplicates \

INPUT=$sample.bam OUTPUT=${sample}_marked.bam METRICS_FILE=$sample.metrics

echo MarkDuplicates `date`

###FixMateInfo###

echo FixMateInfo `date`

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $PICARD FixMateInformation \

INPUT=${sample}_marked.bam OUTPUT=${sample}_marked_fixed.bam SO=coordinate

samtools index ${sample}_marked_fixed.bam

echo FixMateInfo `date`

echo ${sample}_marked_fixed.bam >>files.bamlist

rm $sample.sam $sample.bam ${sample}_marked.bam

done

samtools merge -@ 5 -b files.bamlist merged.bam

samtools index merged.bam上面的代码有一点长,希望大家能用心的来理解,其实就是一个批量处理,对5条lane的测序数据循环处理。 其实正式流程里面我一般是并行的,而不是循环,这里是为了给大家秀一下时间消耗情况,让大家对全基因组重测序分析有一个感性的认知。 最后把所有lane的数据用

samtools merge合并成一个非常大(60G)的bam文件 .

时间消耗情况探索

对L1来说,时间消耗如下:

[main] Real time: 15870.794 sec; CPU: 77463.156 sec

picard.sam.SortSam done. Elapsed time: 45.60 minutes.

picard.sam.markduplicates.MarkDuplicates done. Elapsed time: 64.20 minutes.

picard.sam.FixMateInformation done. Elapsed time: 58.05 minutes.总共耗时约7.2小时,仅仅是对10G的fastq完成比对压缩排序去PCR重复。

如果是其它文件大小的fastq输入数据,那么这个流程耗时如下:

[main] Real time: 9527.240 sec; CPU: 47758.233 sec

[main] Real time: 16000.325 sec; CPU: 80595.629 sec

[main] Real time: 29286.523 sec; CPU: 147524.841 sec

[main] Real time: 28104.568 sec; CPU: 141519.377 sec

picard.sam.SortSam done. Elapsed time: 29.02 minutes.

picard.sam.SortSam done. Elapsed time: 61.26 minutes.

picard.sam.SortSam done. Elapsed time: 98.39 minutes.

picard.sam.SortSam done. Elapsed time: 117.16 minutes.

picard.sam.markduplicates.MarkDuplicates done. Elapsed time: 35.52 minutes.

picard.sam.markduplicates.MarkDuplicates done. Elapsed time: 54.41 minutes.

picard.sam.markduplicates.MarkDuplicates done. Elapsed time: 90.40 minutes.

picard.sam.markduplicates.MarkDuplicates done. Elapsed time: 93.03 minutes.

picard.sam.FixMateInformation done. Elapsed time: 35.92 minutes.

picard.sam.FixMateInformation done. Elapsed time: 66.31 minutes.

picard.sam.FixMateInformation done. Elapsed time: 131.65 minutes.

picard.sam.FixMateInformation done. Elapsed time: 122.31 minutes.前面我们说过,这5条lane的数据其实是可以并行完成这几个步骤的,最长耗时约12小时。 每个数据处理我都分配了5个线程,40G的内存。

GATK重新处理bam文件

主要是针对上一个步骤合并了5个lane之后的

merge.bam文件

-rw-rw-r-- 1 jianmingzeng jianmingzeng 57G Jun 7 11:32 merged.bam

-rw-rw-r-- 1 jianmingzeng jianmingzeng 8.4M Jun 7 12:05 merged.bam.baimerge后需要AddOrReplaceReadGroups处理

因为不同的lane出来的数据都是我本人的全基因组重测续数据,后续处理应该是当做一个样本的,所有需要AddOrReplaceReadGroups处理,代码是:

### AddOrReplaceReadGroups ###

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $PICARD AddOrReplaceReadGroups \

INPUT=${sample}.bam OUTPUT=${sample}_tmp.bam RGID=jmzeng RGLB=lib_all RGPL=illumina RGPU=x10 RGSM=jmzeng

mv ${sample}_tmp.bam ${sample}.bam

samtools index ${sample}.bam 这里是直接跟着GATK官方的最佳实践写的代码,完成对bam文件的预处理。包括RealignerTargetCreator --> IndelRealigner --> BaseRecalibrator --> PrintReads

module load java/1.8.0_91

GENOME=/home/jianmingzeng/reference/genome/human_g1k_v37/human_g1k_v37.fasta

INDEX=/home/jianmingzeng/reference/index/bwa/human_g1k_v37

GATK=/home/jianmingzeng/biosoft/GATK/GenomeAnalysisTK.jar

PICARD=/home/jianmingzeng/biosoft/picardtools/2.9.2/picard.jar

DBSNP=/home/jianmingzeng/annotation/variation/human/dbSNP/All_20160601.vcf.gz

KG_SNP=/home/jianmingzeng/biosoft/GATK/resources/bundle/b37/1000G_phase1.snps.high_confidence.b37.vcf.gz

Mills_indels=/home/jianmingzeng/biosoft/GATK/resources/bundle/b37/Mills_and_1000G_gold_standard.indels.b37.vcf

KG_indels=/home/jianmingzeng/biosoft/GATK/resources/bundle/b37/1000G_phase1.indels.b37.vcf

TMPDIR=/home/jianmingzeng/tmp/software

## samtools and bwa are in the environment

## samtools Version: 1.3.1 (using htslib 1.3.1)

## bwa Version: 0.7.15-r1140

sample='merge'

###RealignerTargetCreator###

echo RealignerTargetCreator `date`

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T RealignerTargetCreator \

-I ${sample}.bam -R $GENOME -o ${sample}_target.intervals \

-known $Mills_indels -known $KG_indels -nt 5

echo RealignerTargetCreator `date`

###IndelRealigner###

echo IndelRealigner `date`

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T IndelRealigner \

-I ${sample}_marked_fixed_split.bam -R $GENOME -targetIntervals ${sample}_target.intervals \

-o ${sample}_realigned.bam -known $Mills_indels -known $KG_indels

echo IndelRealigner `date`

###BaseRecalibrator###

echo BaseRecalibrator `date`

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T BaseRecalibrator \

-I ${sample}_realigned.bam -R $GENOME -o ${sample}_temp.table -knownSites $DBSNP

echo BaseRecalibrator `date`

###PrintReads###

echo PrintReads `date`

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T PrintReads \

-R $GENOME -I ${sample}_realigned.bam -o ${sample}_recal.bam -BQSR ${sample}_temp.table

samtools index ${sample}_recal.bam

echo PrintReads `date`

###delete_intermediate_files###

全基因组重测序分析时间消耗如下:

INFO 15:50:24,097 ProgressMeter - Total runtime 1165.34 secs, 19.42 min, 0.32 hours

INFO 17:21:00,917 ProgressMeter - Total runtime 4265.44 secs, 71.09 min, 1.18 hours

INFO 19:58:23,969 ProgressMeter - Total runtime 9436.69 secs, 157.28 min, 2.62 hours

INFO 23:41:00,540 ProgressMeter - Total runtime 13349.77 secs, 222.50 min, 3.71 hours 可以看到最耗费时间的步骤是最后一个PrintReads

variant calling by gatk hc

这个才是GATK工具的本职工作,就是找出测序数据跟参考基因组的不同之处,代码如下:

module load java/1.8.0_91

GENOME=/home/jianmingzeng/reference/genome/human_g1k_v37/human_g1k_v37.fasta

INDEX=/home/jianmingzeng/reference/index/bwa/human_g1k_v37

GATK=/home/jianmingzeng/biosoft/GATK/GenomeAnalysisTK.jar

PICARD=/home/jianmingzeng/biosoft/picardtools/2.9.2/picard.jar

DBSNP=/home/jianmingzeng/annotation/variation/human/dbSNP/All_20160601.vcf.gz

KG_SNP=/home/jianmingzeng/biosoft/GATK/resources/bundle/b37/1000G_phase1.snps.high_confidence.b37.vcf.gz

Mills_indels=/home/jianmingzeng/biosoft/GATK/resources/bundle/b37/Mills_and_1000G_gold_standard.indels.b37.vcf

KG_indels=/home/jianmingzeng/biosoft/GATK/resources/bundle/b37/1000G_phase1.indels.b37.vcf

TMPDIR=/home/jianmingzeng/tmp/software

## samtools and bwa are in the environment

## samtools Version: 1.3.1 (using htslib 1.3.1)

## bwa Version: 0.7.15-r1140

fq1=P_jmzeng_DHG09057_AH33KVALXX_L1_1.clean.fq.gz

fq2=P_jmzeng_DHG09057_AH33KVALXX_L1_2.clean.fq.gz

sample='merge'

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T HaplotypeCaller \

-R $GENOME -I ${sample}_recal.bam --dbsnp $DBSNP \

-stand_emit_conf 10 -o ${sample}_recal_raw.snps.indels.vcf

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T HaplotypeCaller \

-R $GENOME -I ${sample}_realigned.bam --dbsnp $DBSNP \

-stand_emit_conf 10 -o ${sample}_realigned_raw.snps.indels.vcf时间消耗如下:

INFO 20:40:49,063 ProgressMeter - Total runtime 39243.88 secs, 654.06 min, 10.90 hours

INFO 08:53:17,633 ProgressMeter - Total runtime 43939.69 secs, 732.33 min, 12.21 hours 可以看到对recal.bam的处理比 recal.bam时间上要少2个小时,但是时间均消耗很长。

流程探究

如果只给代码,那么这个教程意义不大,如果给出了input和output,还给出了时间消耗情况,那么这个教程可以说是中上水平了,读者只需要拿到数据就可以自己重复出来,既能估算硬件配置又能对大致的时间消耗有所了解。

但,这仍然不够,对我来说,我还可以介绍为什么要走每一个流程,以及每一个流程到底做了什么。可以这么说,你看完下面的流程探究,基本上就相当于你自己做过了一个全基因组重测序分析实战

我这里就对

L1样本进行解析

首先的BWA

这个没什么好说的,基因组数据的比对首选,耗时取决于fastq文件的reads数目。

CMD: bwa mem -t 5 -R @RG\tID:L1\tSM:L1\tLB:WGS\tPL:Illumina /home/jianmingzeng/reference/index/bwa/human_g1k_v37 P_jmzeng_DHG09057_AH33KVALXX_L1_1.clean.fq.gz P_jmzeng_DHG09057_AH33KVALXX_L1_2.clean.fq.gz

[main] Real time: 15870.794 sec; CPU: 77463.156 sec接下来是PICARD

共3个步骤用到了这个软件,消耗时间及内存分别如下:

picard.sam.SortSam done. Elapsed time: 44.15 minutes. Runtime.totalMemory()=13184794624

picard.sam.markduplicates.MarkDuplicates done. Elapsed time: 53.71 minutes. Runtime.totalMemory()=39832256512

picard.sam.FixMateInformation done. Elapsed time: 53.79 minutes. Runtime.totalMemory()=9425649664

比对得到的都是sam格式数据,文件占硬盘空间太大,一般需要压缩成二进制的bam格式文件,用的是SortSam 至于FixMateInformation步骤仅仅是对bam文件增加了MC和MQ这两个tags

add MC (CIGAR string for mate) and MQ (mapping quality of the mate/next segment) tags 而 markduplicates 步骤就比较复杂了,因为没有选择 REMOVE_DUPLICATES=True 所以并不会去除reads,只是标记一下而已,就是把sam文件的第二列改一下。

Read 119776742 records.

INFO 2017-06-05 10:57:22 MarkDuplicates Marking 14482525 records as duplicates.

INFO 2017-06-05 10:57:22 MarkDuplicates Found 943146 optical duplicate clusters.下面列出了部分被改变的flag值,可以去下面的PICARD网页去查看每个flag的含义。

# https://broadinstitute.github.io/picard/explain-flags.html

# diff -y -W 50 |grep '|'

163 | 1187

83 | 1107

99 | 1123

163 | 1187

147 | 1171

83 | 1107

99 | 1123

99 | 1123

147 | 1171

147 | 1171

99 | 1123

147 | 1171

163 | 1187

83 | 1107最后是GATK

SplitNCigarReads 这个步骤对基因组数据来说可以略去,主要是针对于转录组数据的

命令是:

Program Args: -T SplitNCigarReads -R /home/jianmingzeng/reference/genome/human_g1k_v37/human_g1k_v37.fasta \

-I L1_marked_fixed.bam -o L1_marked_fixed_split.bam \

-rf ReassignOneMappingQuality -RMQF 255 -RMQT 60 -U ALLOW_N_CIGAR_READS 程序运行的log日志是:

INFO 13:04:52,813 ProgressMeter - Total runtime 2398.74 secs, 39.98 min, 0.67 hours

INFO 13:04:52,854 MicroScheduler - 0 reads were filtered out during the traversal out of approximately 120614036 total reads (0.00%)

INFO 13:04:52,854 MicroScheduler - -> 0 reads (0.00% of total) failing BadCigarFilter

INFO 13:04:52,854 MicroScheduler - -> 0 reads (0.00% of total) failing MalformedReadFilter

INFO 13:04:52,855 MicroScheduler - -> 0 reads (0.00% of total) failing ReassignOneMappingQualityFilter 可以看到,对全基因组测序数据来说,这个步骤毫无效果,而且还耗时40分钟,应该略去。

然后是indel区域的重排,需要结合 RealignerTargetCreator 和 IndelRealigner

命令是:

Program Args: -T RealignerTargetCreator -I L1_marked_fixed_split.bam \

-R /home/jianmingzeng/reference/genome/human_g1k_v37/human_g1k_v37.fasta -o L1_target.intervals \

-known /home/jianmingzeng/biosoft/GATK/resources/bundle/b37/Mills_and_1000G_gold_standard.indels.b37.vcf \

-known /home/jianmingzeng/biosoft/GATK/resources/bundle/b37/1000G_phase1.indels.b37.vcf -nt 5 程序运行的log日志是:

INFO 15:50:24,097 ProgressMeter - Total runtime 1165.34 secs, 19.42 min, 0.32 hours

INFO 15:50:24,097 MicroScheduler - 22094746 reads were filtered out during the traversal out of approximately 120826819 total reads (18.29%)

INFO 15:50:24,104 MicroScheduler - -> 0 reads (0.00% of total) failing BadCigarFilter

INFO 15:50:24,104 MicroScheduler - -> 1774279 reads (1.47% of total) failing BadMateFilter

INFO 15:50:24,104 MicroScheduler - -> 14006627 reads (11.59% of total) failing DuplicateReadFilter

INFO 15:50:24,104 MicroScheduler - -> 0 reads (0.00% of total) failing FailsVendorQualityCheckFilter

INFO 15:50:24,104 MicroScheduler - -> 0 reads (0.00% of total) failing MalformedReadFilter

INFO 15:50:24,104 MicroScheduler - -> 0 reads (0.00% of total) failing MappingQualityUnavailableFilter

INFO 15:50:24,105 MicroScheduler - -> 6313840 reads (5.23% of total) failing MappingQualityZeroFilter

INFO 15:50:24,105 MicroScheduler - -> 0 reads (0.00% of total) failing NotPrimaryAlignmentFilter

INFO 15:50:24,105 MicroScheduler - -> 0 reads (0.00% of total) failing Platform454Filter

INFO 15:50:24,105 MicroScheduler - -> 0 reads (0.00% of total) failing UnmappedReadFilter 命令是:

Program Args: -T IndelRealigner -I L1_marked_fixed_split.bam \

-R /home/jianmingzeng/reference/genome/human_g1k_v37/human_g1k_v37.fasta \

-targetIntervals L1_target.intervals -o L1_realigned.bam \

-known /home/jianmingzeng/biosoft/GATK/resources/bundle/b37/Mills_and_1000G_gold_standard.indels.b37.vcf \

-known /home/jianmingzeng/biosoft/GATK/resources/bundle/b37/1000G_phase1.indels.b37.vcf程序运行的log日志是:

INFO 17:21:00,917 ProgressMeter - Total runtime 4265.44 secs, 71.09 min, 1.18 hours

INFO 17:21:00,920 MicroScheduler - 0 reads were filtered out during the traversal out of approximately 120614036 total reads (0.00%)

INFO 17:21:00,920 MicroScheduler - -> 0 reads (0.00% of total) failing BadCigarFilter

INFO 17:21:00,920 MicroScheduler - -> 0 reads (0.00% of total) failing MalformedReadFilter 最后是碱基质量的矫正,需要结合 BaseRecalibrator 和 PrintReads > 命令是:

Program Args: -T BaseRecalibrator -I L1_realigned.bam \

-R /home/jianmingzeng/reference/genome/human_g1k_v37/human_g1k_v37.fasta -o L1_temp.table \

-knownSites /home/jianmingzeng/annotation/variation/human/dbSNP/All_20160601.vcf.gz程序运行的log日志是:

INFO 19:58:23,969 ProgressMeter - Total runtime 9436.69 secs, 157.28 min, 2.62 hours

INFO 19:58:23,970 MicroScheduler - 21179430 reads were filtered out during the traversal out of approximately 120614036 total reads (17.56%)

INFO 19:58:23,970 MicroScheduler - -> 0 reads (0.00% of total) failing BadCigarFilter

INFO 19:58:23,970 MicroScheduler - -> 14073643 reads (11.67% of total) failing DuplicateReadFilter

INFO 19:58:23,970 MicroScheduler - -> 0 reads (0.00% of total) failing FailsVendorQualityCheckFilter

INFO 19:58:23,970 MicroScheduler - -> 0 reads (0.00% of total) failing MalformedReadFilter

INFO 19:58:23,971 MicroScheduler - -> 0 reads (0.00% of total) failing MappingQualityUnavailableFilter

INFO 19:58:23,971 MicroScheduler - -> 7105787 reads (5.89% of total) failing MappingQualityZeroFilter

INFO 19:58:23,971 MicroScheduler - -> 0 reads (0.00% of total) failing NotPrimaryAlignmentFilter

INFO 19:58:23,971 MicroScheduler - -> 0 reads (0.00% of total) failing UnmappedReadFilter 命令是:

Program Args: -T PrintReads -R /home/jianmingzeng/reference/genome/human_g1k_v37/human_g1k_v37.fasta -I L1_realigned.bam -o L1_recal.bam -BQSR L1_temp.table 程序运行的log日志是:

INFO 23:41:00,540 ProgressMeter - Total runtime 13349.77 secs, 222.50 min, 3.71 hours

INFO 23:41:00,542 MicroScheduler - 0 reads were filtered out during the traversal out of approximately 120614036 total reads (0.00%)

INFO 23:41:00,542 MicroScheduler - -> 0 reads (0.00% of total) failing BadCigarFilter

INFO 23:41:00,542 MicroScheduler - -> 0 reads (0.00% of total) failing MalformedReadFilter 可以看到这个步骤非常的耗时,而且bam文件的大小近乎翻倍了。

最后是GATK真正的功能,variant-calling

我这里不仅仅是对最后recal的bam进行variant-calling 步骤,同时也对realign的bam做了,所以下面显示两个时间消耗的记录. 因为GATK的 BaseRecalibrator 步骤太耗费时间,而且极大的增加了bam文件的存储,所以有必要确认这个步骤是否有必要。

命令是:

Program Args: -T HaplotypeCaller -R /home/jianmingzeng/reference/genome/human_g1k_v37/human_g1k_v37.fasta -I L1_recal.bam --dbsnp /home/jianmingzeng/annotation/variation/human/dbSNP/All_20160601.vcf.gz -stand_emit_conf 10 -o L1_recal_raw.snps.indels.vcf 程序运行的log日志是:

INFO 20:40:49,062 ProgressMeter - done 3.101804739E9 10.9 h 12.0 s 100.0% 10.9 h 0.0 s

INFO 20:40:49,063 ProgressMeter - Total runtime 39243.88 secs, 654.06 min, 10.90 hours

INFO 20:40:49,064 MicroScheduler - 22384946 reads were filtered out during the traversal out of approximately 119776742 total reads (18.69%)

INFO 20:40:49,064 MicroScheduler - -> 0 reads (0.00% of total) failing BadCigarFilter

INFO 20:40:49,064 MicroScheduler - -> 13732328 reads (11.46% of total) failing DuplicateReadFilter

INFO 20:40:49,065 MicroScheduler - -> 0 reads (0.00% of total) failing FailsVendorQualityCheckFilter

INFO 20:40:49,065 MicroScheduler - -> 8652618 reads (7.22% of total) failing HCMappingQualityFilter

INFO 20:40:49,066 MicroScheduler - -> 0 reads (0.00% of total) failing MalformedReadFilter

INFO 20:40:49,066 MicroScheduler - -> 0 reads (0.00% of total) failing MappingQualityUnavailableFilter

INFO 20:40:49,066 MicroScheduler - -> 0 reads (0.00% of total) failing NotPrimaryAlignmentFilter

INFO 20:40:49,067 MicroScheduler - -> 0 reads (0.00% of total) failing UnmappedReadFilter 命令是:

Program Args: -T HaplotypeCaller -R /home/jianmingzeng/reference/genome/human_g1k_v37/human_g1k_v37.fasta -I L1_realigned.bam --dbsnp /home/jianmingzeng/annotation/variation/human/dbSNP/All_20160601.vcf.gz -stand_emit_conf 10 -o L1_realigned_raw.snps.indels.vcf 程序运行的log日志是:

INFO 08:53:17,633 ProgressMeter - done 3.101804739E9 12.2 h 14.0 s 100.0% 12.2 h 0.0 s

INFO 08:53:17,633 ProgressMeter - Total runtime 43939.69 secs, 732.33 min, 12.21 hours

INFO 08:53:17,634 MicroScheduler - 22384946 reads were filtered out during the traversal out of approximately 119776742 total reads (18.69%)

INFO 08:53:17,634 MicroScheduler - -> 0 reads (0.00% of total) failing BadCigarFilter

INFO 08:53:17,635 MicroScheduler - -> 13732328 reads (11.46% of total) failing DuplicateReadFilter

INFO 08:53:17,635 MicroScheduler - -> 0 reads (0.00% of total) failing FailsVendorQualityCheckFilter

INFO 08:53:17,635 MicroScheduler - -> 8652618 reads (7.22% of total) failing HCMappingQualityFilter

INFO 08:53:17,636 MicroScheduler - -> 0 reads (0.00% of total) failing MalformedReadFilter

INFO 08:53:17,636 MicroScheduler - -> 0 reads (0.00% of total) failing MappingQualityUnavailableFilter

INFO 08:53:17,636 MicroScheduler - -> 0 reads (0.00% of total) failing NotPrimaryAlignmentFilter

INFO 08:53:17,637 MicroScheduler - -> 0 reads (0.00% of total) failing UnmappedReadFilter 这个不同的bam文件首先大小就不一致,其次找变异所消耗的时间也不一样,找出的变异数目也不同的,至于具体差别在哪里,就不是本文探索范围了,我在我在直播基因组里面有提到过这一点。

我对realign和recal以及原始的bam都用了HaplotypeCaller找变异,得到的vcf文件如下:

1.1G Jun 21 02:29 jmzeng_merge_raw.snps.indels.vcf

1.1G Jun 21 02:15 jmzeng_realigned_raw.snps.indels.vcf

1.1G Jun 20 21:20 jmzeng_recal_raw.snps.indels.vcf这是最原始的变异文件,我们需要进行过滤,拆分SNP和INDEL,这样才能更好的对它们两两比较。

拆分SNP和INDEL并过滤低质量位点

代码如下:

module load java/1.8.0_91

GENOME=/home/jianmingzeng/reference/genome/human_g1k_v37/human_g1k_v37.fasta

GATK=/home/jianmingzeng/biosoft/GATK/GenomeAnalysisTK.jar

TMPDIR=/home/jianmingzeng/tmp/software

sample=$1

## for SNP

: '

'

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T SelectVariants -R $GENOME \

-selectType SNP \

-V ${sample}_raw.snps.indels.vcf -o ${sample}_raw_snps.vcf

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T VariantFiltration -R $GENOME \

--filterExpression "QD < 2.0 || FS > 60.0 || MQ < 40.0 || MQRankSum < -12.5 || ReadPosRankSum < -8.0" \

--filterName "my_snp_filter" \

-V ${sample}_raw_snps.vcf -o ${sample}_filtered_snps.vcf

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T SelectVariants -R $GENOME \

--excludeFiltered \

-V ${sample}_filtered_snps.vcf -o ${sample}_filtered_PASS.snps.vcf

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T VariantEval -R $GENOME \

-eval ${sample}_filtered_PASS.snps.vcf -o ${sample}_filtered_PASS.snps.vcf.eval

## for INDEL

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T SelectVariants -R $GENOME \

-selectType INDEL \

-V ${sample}_raw.snps.indels.vcf -o ${sample}_raw_indels.vcf

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T VariantFiltration -R $GENOME \

--filterExpression "QD < 2.0 || FS > 200.0 || ReadPosRankSum < -20.0" \

--filterName "my_indel_filter" \

-V ${sample}_raw_indels.vcf -o ${sample}_filtered_indels.vcf

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T SelectVariants -R $GENOME \

--excludeFiltered \

-V ${sample}_filtered_indels.vcf -o ${sample}_filtered_PASS.indels.vcf

java -Djava.io.tmpdir=$TMPDIR -Xmx40g -jar $GATK -T VariantEval -R $GENOME \

-eval ${sample}_filtered_PASS.indels.vcf -o ${sample}_filtered_PASS.indels.vcf.eval要深度理解这个代码请点击自行阅读文档。 其实我本人不大喜欢用这个工具的各种参数,我比较喜欢自行写脚本来过滤vcf文件。

这样得到的文件如下:

801242 jmzeng_merge_filtered_indels.vcf

760890 jmzeng_merge_filtered_PASS.indels.vcf

3812094 jmzeng_merge_filtered_PASS.snps.vcf

4034168 jmzeng_merge_filtered_snps.vcf

801240 jmzeng_merge_raw_indels.vcf

4837892 jmzeng_merge_raw.snps.indels.vcf

4034166 jmzeng_merge_raw_snps.vcf

801963 jmzeng_realigned_filtered_indels.vcf

761510 jmzeng_realigned_filtered_PASS.indels.vcf

3812442 jmzeng_realigned_filtered_PASS.snps.vcf

4034797 jmzeng_realigned_filtered_snps.vcf

801961 jmzeng_realigned_raw_indels.vcf

4839256 jmzeng_realigned_raw.snps.indels.vcf

4034795 jmzeng_realigned_raw_snps.vcf

793611 jmzeng_recal_filtered_indels.vcf

754755 jmzeng_recal_filtered_PASS.indels.vcf

3784343 jmzeng_recal_filtered_PASS.snps.vcf

4010670 jmzeng_recal_filtered_snps.vcf

793609 jmzeng_recal_raw_indels.vcf

4806696 jmzeng_recal_raw.snps.indels.vcf

4010668 jmzeng_recal_raw_snps.vcf很容易理解: * 对recal的bam得到的变异vcf文件来说,总共是480万位点,拆分成401万的SNP和79万的INDEL,然后经过过滤后剩下378万的SNP和75万的INDEL。 * 对原始的bam得到的变异vcf文件来说, 总共是483万位点,拆分成403万的SNP和80万的INDEL,然后经过过滤后剩下381万的SNP和76万的INDEL。 * 对重排的bam得到的变异vcf文件来说, 总共是483万位点,拆分成403万的SNP和80万的INDEL,然后经过过滤后剩下381万的SNP和76万的INDEL。

从位点数量级来说,原始的bam和重排的bam得到的变异vcf文件没区别,所以需要用专业的工具来具体比较它们里面的每一个位点。 我这里还是选择SnpEff套件里面的SnpSift工具。

首先比较SNP位点

代码如下:

java -jar ~/biosoft/SnpEff/snpEff/SnpSift.jar concordance -v ../jmzeng_merge_filtered_PASS.snps.vcf ../jmzeng_realigned_filtered_PASS.snps.vcf 1>concordance.txt 2>SnpSift_Concordance.log

java -jar ~/biosoft/SnpEff/snpEff/SnpSift.jar concordance -v ../jmzeng_recal_filtered_PASS.snps.vcf ../jmzeng_realigned_filtered_PASS.snps.vcf 1>concordance.txt 2>SnpSift_Concordance.log

java -jar ~/biosoft/SnpEff/snpEff/SnpSift.jar concordance -v ../jmzeng_recal_filtered_PASS.snps.vcf ../jmzeng_merge_filtered_PASS.snps.vcf 1>concordance.txt 2>SnpSift_Concordance.log比较的结果如下:

Number of samples:

1 File ../jmzeng_merge_filtered_PASS.snps.vcf

1 File ../jmzeng_realigned_filtered_PASS.snps.vcf

1 Both files

# Errors:

ALT field does not match 31

Number of samples:

1 File ../jmzeng_recal_filtered_PASS.snps.vcf

1 File ../jmzeng_realigned_filtered_PASS.snps.vcf

1 Both files

# Errors:

ALT field does not match 204

Number of samples:

1 File ../jmzeng_recal_filtered_PASS.snps.vcf

1 File ../jmzeng_merge_filtered_PASS.snps.vcf

1 Both files

# Errors:

ALT field does not match 208可以看到对高质量的SNP位点来说,3种bam文件得到SNP信息差别很微弱,在可接受范围内。但是我们不能忽视原始的bam和重排的bam得到的变异vcf文件要比recal后的少了近两万这个事实!!!

接着比较INDEL位点

代码如下:

java -jar ~/biosoft/SnpEff/snpEff/SnpSift.jar concordance -v ../jmzeng_merge_filtered_PASS.indels.vcf ../jmzeng_realigned_filtered_PASS.indels.vcf 1>concordance.txt 2>SnpSift_Concordance.log

java -jar ~/biosoft/SnpEff/snpEff/SnpSift.jar concordance -v ../jmzeng_recal_filtered_PASS.indels.vcf ../jmzeng_realigned_filtered_PASS.indels.vcf 1>concordance.txt 2>SnpSift_Concordance.log

java -jar ~/biosoft/SnpEff/snpEff/SnpSift.jar concordance -v ../jmzeng_recal_filtered_PASS.indels.vcf ../jmzeng_merge_filtered_PASS.indels.vcf 1>concordance.txt 2>SnpSift_Concordance.log比较的结果如下:

Number of samples:

1 File ../jmzeng_merge_filtered_PASS.indels.vcf

1 File ../jmzeng_realigned_filtered_PASS.indels.vcf

1 Both files

# Errors:

REF fields does not match 28

ALT field does not match 45

Number of samples:

1 File ../jmzeng_recal_filtered_PASS.indels.vcf

1 File ../jmzeng_merge_filtered_PASS.indels.vcf

1 Both files

# Errors:

REF fields does not match 1295

ALT field does not match 964

Number of samples:

1 File ../jmzeng_recal_filtered_PASS.indels.vcf

1 File ../jmzeng_realigned_filtered_PASS.indels.vcf

1 Both files

# Errors:

REF fields does not match 1276

ALT field does not match 947INDEL本身对参数非常敏感,这时候不仅仅是数量的差异,而且本身找到的位点突变情况的差异也不少。

所以我的结论是,GATK的BEST PRACTISE的每个步骤都是必须的!虽然他们非常耗时,但是对结果准确性的改进的确非常显著。 如果要想把测序数据在临床上面应用,那么每一个步骤都是非常有意义的。

比如,如果我们来分析realign之后的高质量SNP为什么会有31个的ALT改变了呢?

21 10716592

21 10701512

21 10700605

20 26317761

19 15787221

18 18515822

17 25266293

16 35230302

16 33975649

16 33972478

10 42400348

10 42393437

9 66455306

4 49111623

1 142537167

Y 58977742

Y 13478115

X 61909282

X 61730552

X 61721098简单看了几眼, 发现都是在染色体的中心粒的地方

再次介绍一下我的这次基因组重测续数据共5条lane,都是单独的PE150的fastq文件。

如果仅对L1这条lane数据进行处理

首先是BWA的比对耗时如下:

[main] Real time: 15870.794 sec; CPU: 77463.156 sec

picard.sam.SortSam done. Elapsed time: 45.60 minutes.

picard.sam.markduplicates.MarkDuplicates done. Elapsed time: 64.20 minutes.

picard.sam.FixMateInformation done. Elapsed time: 58.05 minutes.然后是GATK对bam文件的一些预处理,步骤是:

RealignerTargetCreator --> IndelRealigner --> BaseRecalibrator --> PrintReads 后面我会讲到这些步骤是否是必须的。

耗时如下:

INFO 15:50:24,097 ProgressMeter - Total runtime 1165.34 secs, 19.42 min, 0.32 hours

INFO 17:21:00,917 ProgressMeter - Total runtime 4265.44 secs, 71.09 min, 1.18 hours

INFO 19:58:23,969 ProgressMeter - Total runtime 9436.69 secs, 157.28 min, 2.62 hours

INFO 23:41:00,540 ProgressMeter - Total runtime 13349.77 secs, 222.50 min, 3.71 hours 可以看到对L1这条lane数据来说,整个流程耗时才不到10个小时,还算是可接受范围内的。

接下来用HaplotypeCaller找变异

这个步骤我对realign的bam和recal的bam分别处理了,耗时如下:

INFO 20:40:49,063 ProgressMeter - Total runtime 39243.88 secs, 654.06 min, 10.90 hours

INFO 08:53:17,633 ProgressMeter - Total runtime 43939.69 secs, 732.33 min, 12.21 hours 对bam文件找变异的时间取决于reads数量的多少以及这些reads覆盖的基因组区域大小,虽然一条lane的数据量很小,但它仍然是全基因组测序,如果是全外显子测序这个耗时是不一样的。

整个L1这条lane数据(120M的reads)处理后的文件大小如下所示:

3.0M Jun 7 01:14 L1.bam.bai

8.8G Jun 7 02:33 L1_marked.bam

9.0G Jun 7 03:31 L1_marked_fixed.bam

3.3M Jun 7 03:36 L1_marked_fixed.bam.bai

2.6K Jun 7 02:33 L1.metrics

8.2M Jun 5 17:21 L1_realigned.bai

9.0G Jun 5 17:21 L1_realigned.bam

8.2M Jun 5 23:41 L1_recal.bai

27G Jun 5 23:41 L1_recal.bam

8.1M Jun 5 23:53 L1_recal.bam.bai

39M Jun 5 15:50 L1_target.intervals

320K Jun 5 19:58 L1_temp.table因为我的这次基因组重测续数据共5条lane,这5条lane的数据其实是可以并行完成这几个步骤的,最长耗时约12小时。 每个数据处理我都分配了 5个线程, 40G的内存。

如果merge后不进行AddOrReplaceReadGroups处理,意味着要把5条lane的数据当做是不同的样本,这样后续处理这5个lane的bam矫正以及找变异都是独立进行的,虽然最后生成的vcf文件只有一个,但是每条lane都有独立的基因型。 realign和recal耗时如下:

INFO 17:54:59,396 ProgressMeter - Total runtime 5194.10 secs, 86.57 min, 1.44 hours

INFO 02:04:10,907 ProgressMeter - Total runtime 22558.84 secs, 375.98 min, 6.27 hours

INFO 18:48:45,762 ProgressMeter - Total runtime 60267.18 secs, 1004.45 min, 16.74 hours

INFO 21:30:54,519 ProgressMeter - Total runtime 96119.87 secs, 1602.00 min, 26.70 hours 同样还是对realign的bam和recal的bam分别用HaplotypeCaller找变异

INFO 19:36:31,960 ProgressMeter - Total runtime 201031.47 secs, 3350.52 min, 55.84 hours

INFO 22:59:21,693 ProgressMeter - Total runtime 184944.78 secs, 3082.41 min, 51.37 hours 可以看到这个时候的耗时相比仅针对一条lane已经是非常恐怖了,不仅仅是因为这个时候reads数量增多,而且是因为5条lane独立样本处理。

如果merge后进行AddOrReplaceReadGroups处理,也就是正确的做法下,realign和recal耗时如下:

INFO 15:52:21,739 ProgressMeter - Total runtime 3573.62 secs, 59.56 min, 0.99 hours

INFO 22:46:39,615 ProgressMeter - Total runtime 24853.46 secs, 414.22 min, 6.90 hours

INFO 16:06:14,340 ProgressMeter - Total runtime 62366.41 secs, 1039.44 min, 17.32 hours

INFO 18:18:08,004 ProgressMeter - Total runtime 94304.46 secs, 1571.74 min, 26.20 hours 这个耗时跟上面把lane当做是独立样本的没有什么区别,因为耗时取决于reads数据量。

接下来找变异,我不仅仅是对realign和recal,还加入了最原始的bam,全部耗时如下:

INFO 02:29:32,680 ProgressMeter - Total runtime 149229.64 secs, 2487.16 min, 41.45 hours

INFO 02:15:39,234 ProgressMeter - Total runtime 148379.91 secs, 2473.00 min, 41.22 hours

INFO 21:20:51,032 ProgressMeter - Total runtime 130663.06 secs, 2177.72 min, 36.30 hours可以看到这些耗时都显著的小于把lane当做独立样本。

全部流程输出的文件大小如下:

59G Jun 14 14:17 jmzeng.bam

8.4M Jun 14 14:52 jmzeng.bam.bai

1.1G Jun 21 02:29 jmzeng_merge_raw.snps.indels.vcf

12M Jun 21 02:29 jmzeng_merge_raw.snps.indels.vcf.idx

8.4M Jun 14 22:46 jmzeng_realigned.bai

59G Jun 14 22:46 jmzeng_realigned.bam

1.1G Jun 21 02:15 jmzeng_realigned_raw.snps.indels.vcf

12M Jun 21 02:15 jmzeng_realigned_raw.snps.indels.vcf.idx

8.5M Jun 16 18:18 jmzeng_recal.bai

161G Jun 16 18:18 jmzeng_recal.bam

8.5M Jun 16 19:39 jmzeng_recal.bam.bai

1.1G Jun 20 21:20 jmzeng_recal_raw.snps.indels.vcf

12M Jun 20 21:20 jmzeng_recal_raw.snps.indels.vcf.idx

47M Jun 14 15:52 jmzeng_target.intervals

323K Jun 15 16:06 jmzeng_temp.table值得注意的是,recal之后的bam文件是原始bam的3倍大小,特别耗费存储空间。

接下来我会讲解realign和recal步骤的必要性,毕竟这两个步骤也的确太耗时了,尤其是recal,不仅仅耗时还特别占硬盘存储。

6.2.1.2 tro家系外显子数据分析

外显子组测序(whole exome sequencing, WES)是指利用序列捕获技术将全基因组外显子区域DNA捕捉并富集后进行高通量测序的基因组分析方法。在人类基因中大约有18万个外显子,占人类基因组的1%,约30 Mb。相比于全基因组测序,外显子组测序更加经济、高效,目前已广泛应用于遗传病和癌症研究中。

在各种环境因素的作用下,机体某些体细胞染色体上发生的变异破坏或改变了某些重要的生物学过程,体细胞可能会因此异常增生而转变为肿瘤细胞。对于癌症研究,一般选取患病个体配对的癌组织和癌旁组织或患病个体组织样本及配对的外周血样本进行外显子组学研究。由于不同患病个体之间没有血缘关系,遗传背景相差较大。而在遗传病领域一般是对患病个体的父母一同测序,叫做 基于trio的全外显子组测序。

基于trio的全外显子组测序已经被证实是一种对于智力障碍(intellectual disability, ID)和先天性畸形(congenital malformation, CM)患者的致病基因检测非常有效的策略。

目录如下: - 测序质量控制 - snp-calling - snp-filter - 不同个体的比较 - 不同软件比较 - annovar注释 - de novo变异情况

第一步:测序质量控制

这一步主要看看这些外显子测序数据的测序质量如何:

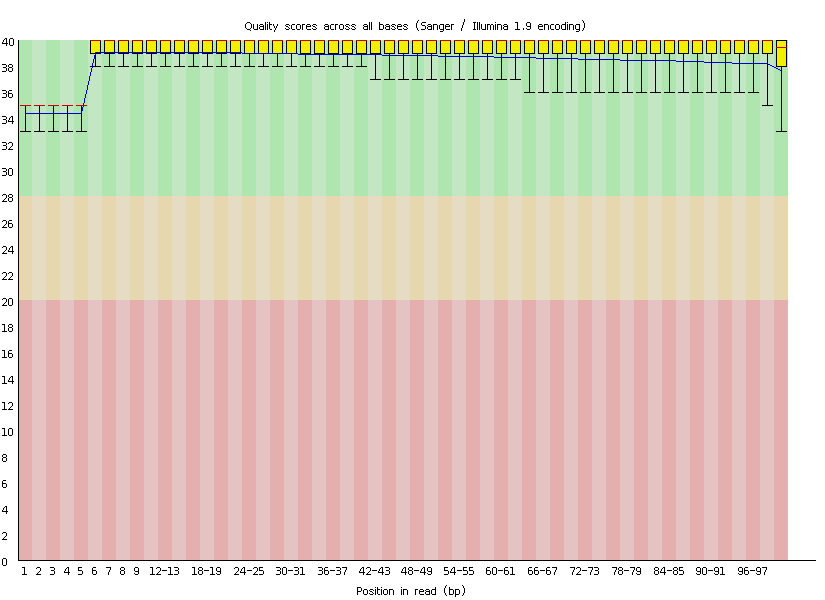

首先用fastqc处理,会出一些图表,通常是不会有问题的,毕竟公司不想砸自己的牌子。

然后粗略统计下平均测序深度及目标区域覆盖度,这个是重点,不过一般没问题的,因为现在芯片捕获技术非常成熟了,而且实验水平大幅提升,没有以前那么多的问题了。

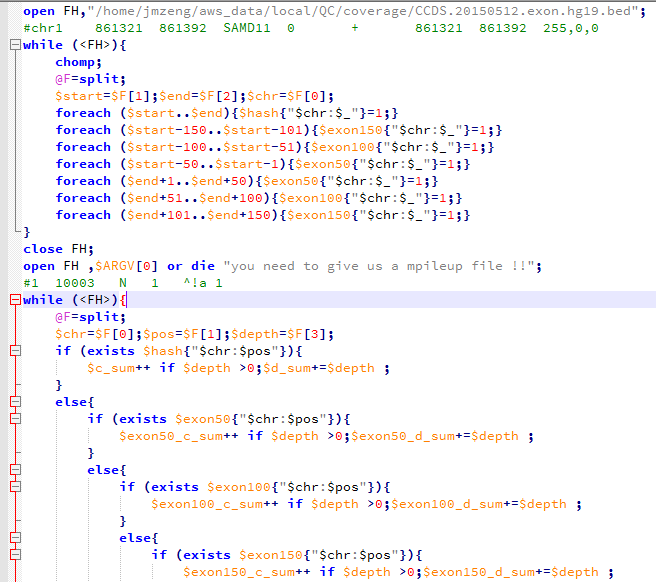

这个外显子项目的测序文件中mpileup文件是1371416525行,意味着总的测序长度是1.3G,以前我接触的一般是600M左右的。因为外显子目标区域并不大,就34729283bp,也就是约35M,即使加上侧翼长度。

54692160:外显子加上前后50bp

73066288:外显子加上前后100bp

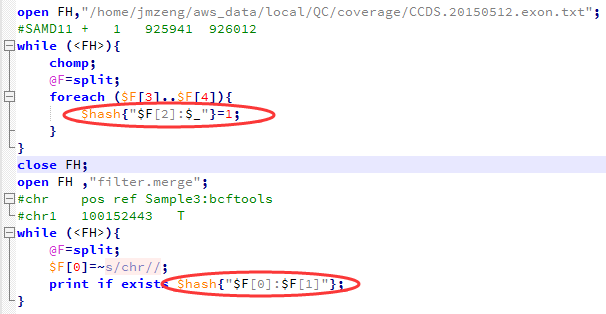

90362533:外显子加上前后150bp然后我要根据外显子记录文件对mpileup文件进行计数,统计外显子的coverage还有测序深度,这个脚本其实蛮有难度的。

我前面提到过外显子组的序列仅占全基因组序列的1%左右,而我在NCBI里面拿到 consensus coding sequence (CCDS)记录CCDS.20150512.txt文件,是基于hg38版本的,需要首先转换成hg19才可以来计算这次测序项目的覆盖度和平均测序深度。

参考:http://www.bio-info-trainee.com/?p=990 ( liftover基因组版本之间的coordinate转换)

awk '{print "chr"$3,$4,$5,$1,0,$2,$4,$5,"255,0,0"}' CCDS.20150512.exon.txt >CCDS.20150512.exon.hg38.bed

~/bio-soft/liftover/liftOver CCDS.20150512.exon.hg38.bed ~/bio-soft/liftover/hg38ToHg19.over.chain CCDS.20150512.exon.hg19.bed unmap下面这个程序就是读取转换好的外显子记录的数据,对一家三口一起统计,然后再读取每个样本的20G左右的mpileup文件进行统计,所以很耗费时间。

外显子目标区域平均测序深度接近100X,所以很明显是非常好的捕获效率啦!而全基因组背景深度才3.3,这符合实验原理,即与探针杂交碱基多的片段比少的片段更易被捕获。对非特异杂交的基因组覆盖度非特异的背景 DNA 也进行了测序。

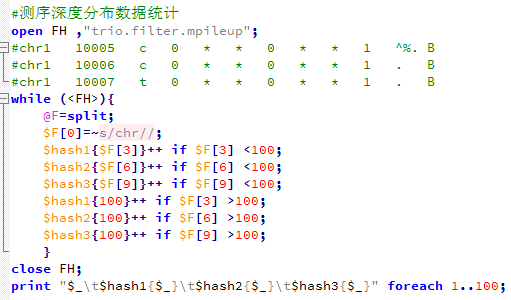

接下来对测序深度进行简单统计,脚本如下,但是这个图没多大意思因为我们的外显子的35M区域平均都接近100X的测序量。

第二步:找变异位点

准备文件:下载必备的软件和参考基因组数据

软件

ps:还有samtools,freebayes和varscan软件,我以前下载过,这次就没有再弄了,但是下面会用到

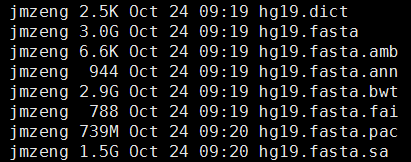

参考基因组

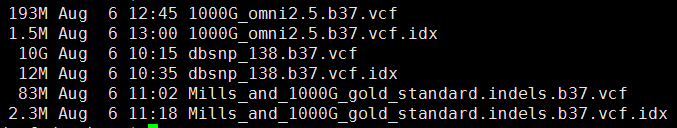

参考突变数据

- 下载数据

- bwa比对

- sam转为bam,并sort好

- 标记PCR重复,并去除

- 产生需要重排的坐标记录

- 根据重排记录文件把比对结果重新比对

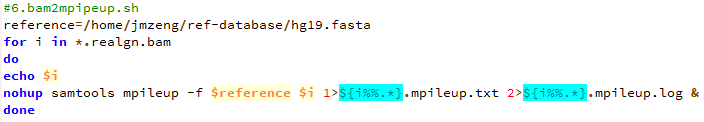

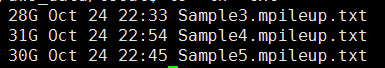

- 把最终的bam文件转为mpileup文件

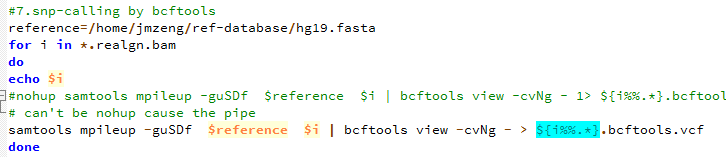

- 用bcftools 来call snp

9 用freebayes来call snp

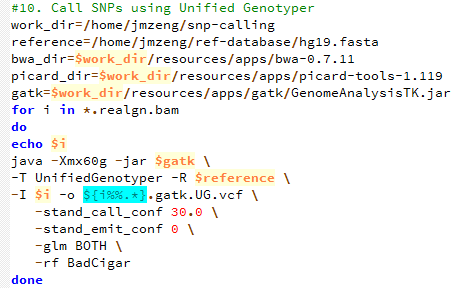

- 用gatk来call snp

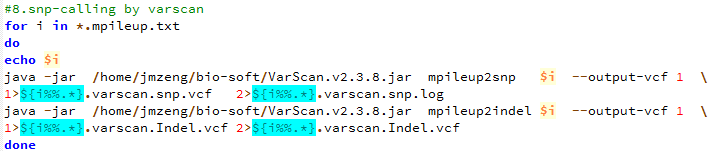

- 用varscan来call snp

第三步:过滤变异位点

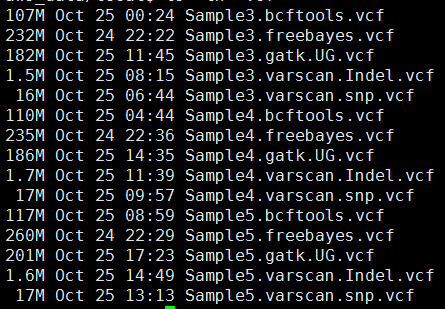

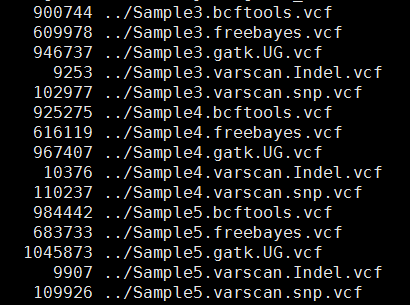

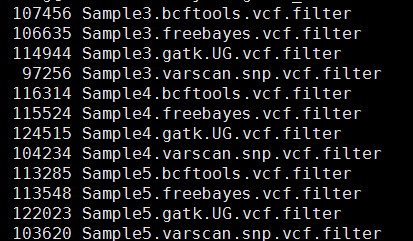

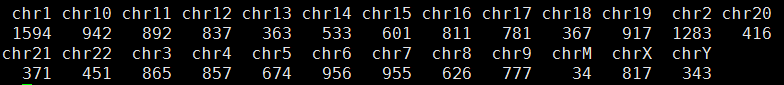

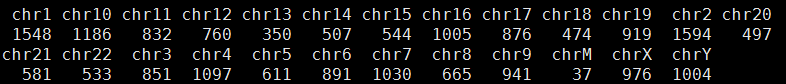

其中freebayes,bcftools,gatk都是把所有的snp细节都call出来了,可以看到下面这些软件的结果有的高达一百多万个snp,而一般文献都说外显子组测序可鉴定约8万个变异。

这样得到突变太多了,所以需要过滤。这里过滤的统一标准都是qual大于20,测序深度大于10。过滤之后的snp数量如下

perl -alne '{next if $F[5]<20;/DP=(\d+)/;next if $1<10;next if /INDEL/;/(DP4=.*?);/;print "$F[0]\t$F[1]\t$F[3]\t$F[4]:$1"}' Sample3.bcftools.vcf >Sample3.bcftools.vcf.filter

perl -alne '{next if $F[5]<20;/DP=(\d+)/;next if $1<10;next if /INDEL/;/(DP4=.*?);/;print "$F[0]\t$F[1]\t$F[3]\t$F[4]:$1"}' Sample4.bcftools.vcf >Sample4.bcftools.vcf.filter

perl -alne '{next if $F[5]<20;/DP=(\d+)/;next if $1<10;next if /INDEL/;/(DP4=.*?);/;print "$F[0]\t$F[1]\t$F[3]\t$F[4]:$1"}' Sample5.bcftools.vcf >Sample5.bcftools.vcf.filter

perl -alne '{next if $F[5]<20;/DP=(\d+)/;next if $1<10;next unless /TYPE=snp/;@tmp=split/:/,$F[9];print "$F[0]\t$F[1]\t$F[3]\t$F[4]:$tmp[0]:$tmp[1]"}' Sample3.freebayes.vcf > Sample3.freebayes.vcf.filter

perl -alne '{next if $F[5]<20;/DP=(\d+)/;next if $1<10;next unless /TYPE=snp/;@tmp=split/:/,$F[9];print "$F[0]\t$F[1]\t$F[3]\t$F[4]:$tmp[0]:$tmp[1]"}' Sample4.freebayes.vcf > Sample4.freebayes.vcf.filter

perl -alne '{next if $F[5]<20;/DP=(\d+)/;next if $1<10;next unless /TYPE=snp/;@tmp=split/:/,$F[9];print "$F[0]\t$F[1]\t$F[3]\t$F[4]:$tmp[0]:$tmp[1]"}' Sample5.freebayes.vcf > Sample5.freebayes.vcf.filter

perl -alne '{next if $F[5]<20;/DP=(\d+)/;next if $1<10;next if length($F[3]) >1;next if length($F[4]) >1;@tmp=split/:/,$F[9];print "$F[0]\t$F[1]\t$F[3]\t$F[4]:$tmp[0]:$tmp[1]:$tmp[2]"}' Sample3.gatk.UG.vcf >Sample3.gatk.UG.vcf.filter

perl -alne '{next if $F[5]<20;/DP=(\d+)/;next if $1<10;next if length($F[3]) >1;next if length($F[4]) >1;@tmp=split/:/,$F[9];print "$F[0]\t$F[1]\t$F[3]\t$F[4]:$tmp[0]:$tmp[1]:$tmp[2]"}' Sample4.gatk.UG.vcf >Sample4.gatk.UG.vcf.filter

perl -alne '{next if $F[5]<20;/DP=(\d+)/;next if $1<10;next if length($F[3]) >1;next if length($F[4]) >1;@tmp=split/:/,$F[9];print "$F[0]\t$F[1]\t$F[3]\t$F[4]:$tmp[0]:$tmp[1]:$tmp[2]"}' Sample5.gatk.UG.vcf >Sample5.gatk.UG.vcf.filter

perl -alne '{@tmp=split/:/,$F[9];next if $tmp[3]<10;print "$F[0]\t$F[1]\t$F[3]\t$F[4]:$tmp[0]:$tmp[3]"}' Sample3.varscan.snp.vcf >Sample3.varscan.snp.vcf.filter

perl -alne '{@tmp=split/:/,$F[9];next if $tmp[3]<10;print "$F[0]\t$F[1]\t$F[3]\t$F[4]:$tmp[0]:$tmp[3]"}' Sample4.varscan.snp.vcf >Sample4.varscan.snp.vcf.filter

perl -alne '{@tmp=split/:/,$F[9];next if $tmp[3]<10;print "$F[0]\t$F[1]\t$F[3]\t$F[4]:$tmp[0]:$tmp[3]"}' Sample5.varscan.snp.vcf >Sample5.varscan.snp.vcf.filter

这样不同工具产生的snp记录数就比较整齐了,我们先比较四种不同工具的call snp的情况,然后再比较三个人的区别。

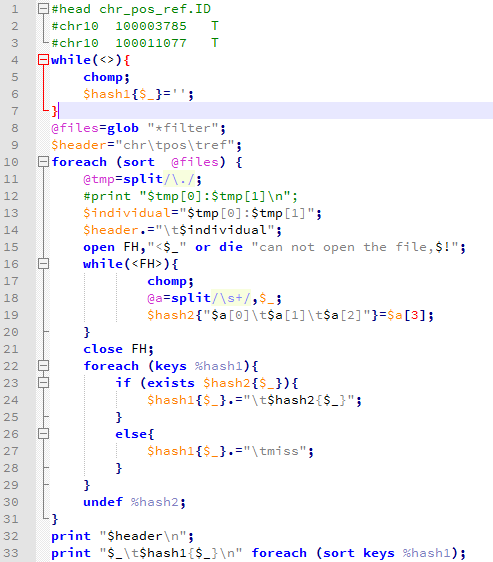

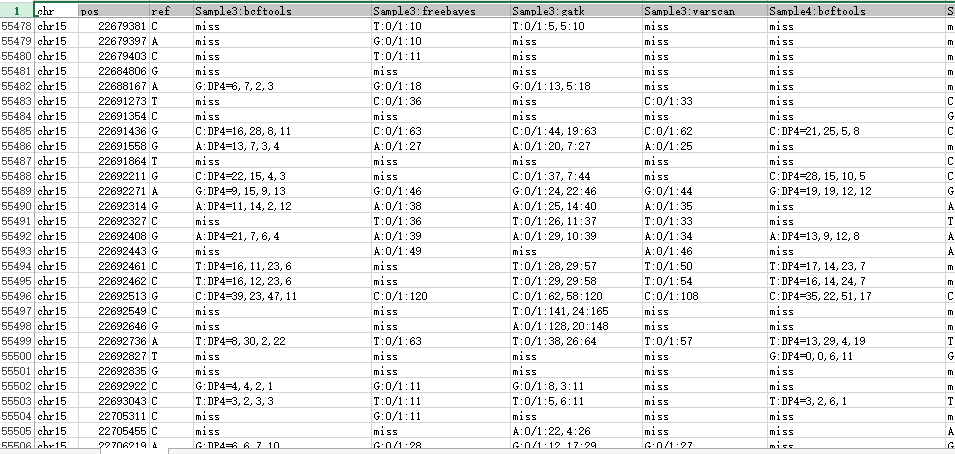

然后写了一个程序把所有的snp合并起来比较

得到了一个很有趣的表格,我放在excel里面看了看 ,主要是要看生物学意义,但是我的生物学知识好多都忘了,得重新学习了

第四步:不同个体的比较

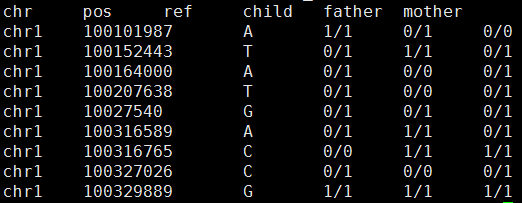

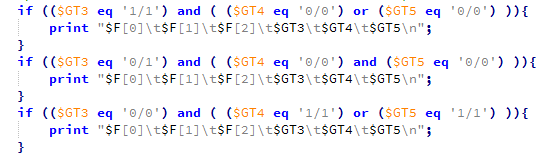

3-4-5分别就是孩子、父亲、母亲

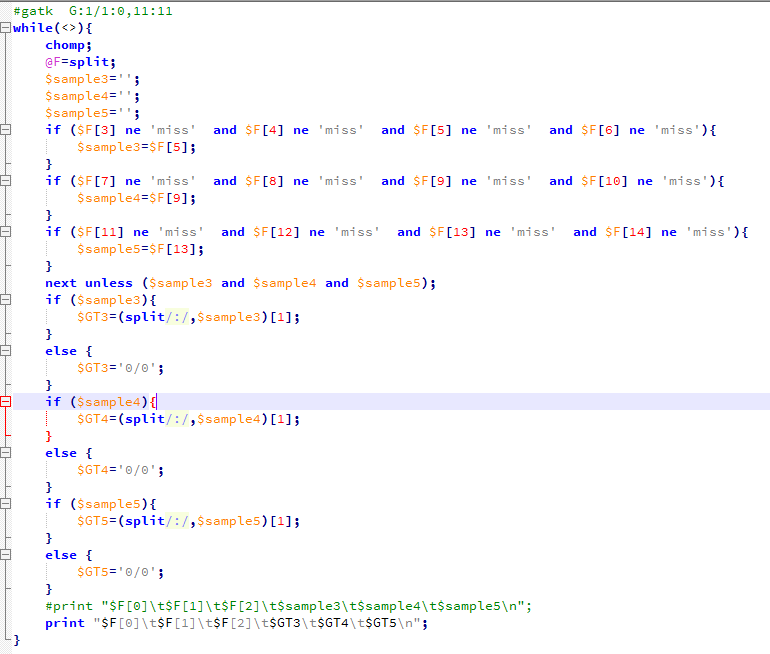

我对每个个体取他们的四种软件的公共snp来进行分析,并且只分析基因型,看看是否符合孟德尔遗传定律。

结果如下:

粗略看起来好像很少不符合孟德尔遗传定律,然后我写了程序计算。

总共127138个可以计算的位点,共有18063个位点不符合孟德尔遗传定律。

我检查了一下不符合的原因,发现我把

chr1 100617887 C T:DP4=0,0,36,3 T:1/1:40 T:1/1:0,40:40 miss T:DP4=0,0,49,9 T:1/1:59 T:1/1:0,58:59 miss T:DP4=0,0,43,8 T:1/1:53 T:1/1:0,53:53 T:1/1:50

计算成了chr1 100617887 C 0/0 0/0 1/1 所以认为不符合,因为我认为只有四个软件都认为是snp的我才当作是snp的基因型,否则都是0/0。那么我就改写了程序,全部用gatk结果来计算。这次可以计算的snp有个176036,不符合的有20309,而且我看了不符合的snp的染色体分布,Y染色体有点异常。

但是很失败,没什么发现。

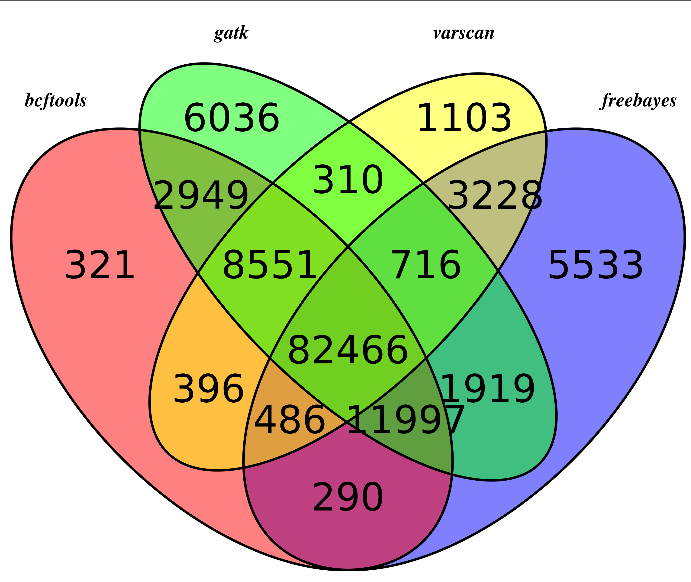

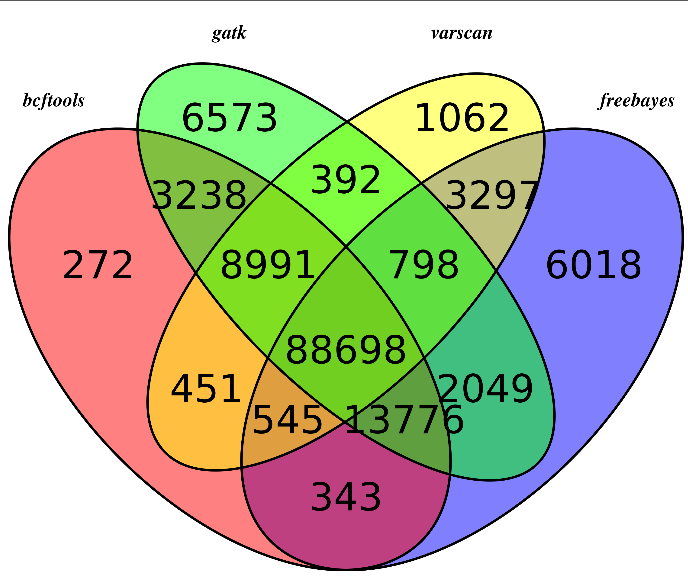

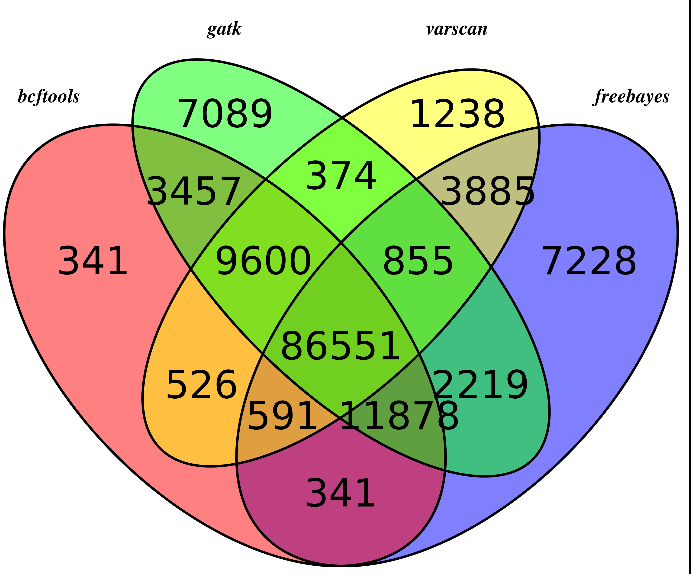

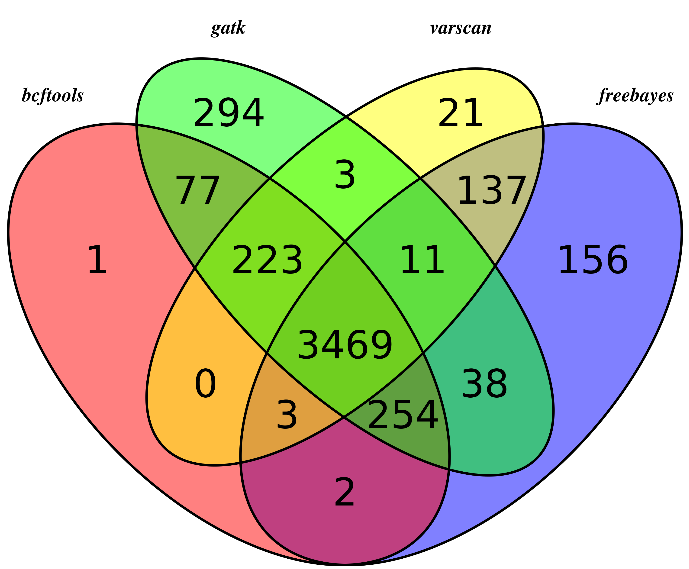

第五步:不同软件比较

主要是画韦恩图看看,参考:http://www.bio-info-trainee.com/?p=893

对合并而且过滤的高质量snp信息来看看四种不同的snp calling软件的差异

我们用R语言来画韦恩图

可以看出不同软件的差异还是蛮大的,所以我只选四个软件的公共snp来进行分析

首先是sample3

然后是sample4

然后是sample5

可以看出,不同的软件差异还是蛮大的,所以我重新比较了一下,这次只比较,它们不同的软件在exon位点上面的snp的差异,毕竟,我们这次是外显子测序,重点应该是外显子snp

然后我们用同样的程序,画韦恩图,这次能明显看出来了,大部分的snp位点都至少有两到三个软件支持

所以,只有测序深度达到一定级别,用什么软件来做snp-calling其实影响并不大。

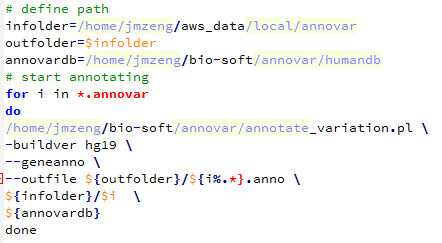

第六步:用annovar注释

使用annovar软件参考自:http://www.bio-info-trainee.com/?p=641

/home/jmzeng/bio-soft/annovar/convert2annovar.pl -format vcf4 Sample3.varscan.snp.vcf > Sample3.annovar

/home/jmzeng/bio-soft/annovar/convert2annovar.pl -format vcf4 Sample4.varscan.snp.vcf > Sample4.annovar

/home/jmzeng/bio-soft/annovar/convert2annovar.pl -format vcf4 Sample5.varscan.snp.vcf > Sample5.annovar然后用下面这个脚本批量注释

Reading gene annotation from /home/jmzeng/bio-soft/annovar/humandb/hg19_refGene.txt … Done with 50914 transcripts (including 11516 without coding sequence annotation) for 26271 unique genes

最后查看结果可知,真正在外显子上面的突变并不多

23515 Sample3.anno.exonic_variant_function

23913 Sample4.anno.exonic_variant_function

24009 Sample5.anno.exonic_variant_functionannovar软件就是把我们得到的十万多个snp分类了,看看这些snp分别是基因的哪些位置,是否引起蛋白突变,位置信息如下:

downstream

exonic

exonic;splicing

intergenic

intronic

ncRNA_exonic

ncRNA_intronic

ncRNA_splicing

ncRNA_UTR3

ncRNA_UTR5

splicing

upstream

upstream;downstream

UTR3

UTR5

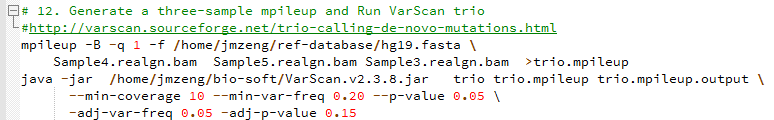

UTR5;UTR3第七步:de novo变异情况

de novo变异寻找也属于snp-calling的一部分,但是有点不同的就是该软件考虑了一家三口的测序文件,找de novo突变。

功能介绍:http://varscan.sourceforge.net/trio-calling-de-novo-mutations.html

而且还专门有一篇文章讲ASD和autism与de novo变异的关系,但个人感觉文章不清不楚,没什么意思

Trio Calling for de novo Mutations

Min coverage: 10

Min reads2: 4

Min var freq: 0.2

Min avg qual: 15

P-value thresh: 0.05

Adj. min reads2: 2

Adj. var freq: 0.05

Adj. p-value: 0.15Reading input from trio.filter.mpileup

1371416525 bases in pileup file (137M的序列)

83123183 met the coverage requirement of 10 (其中有83M的测序深度大于10X)

145104 variant positions (132268 SNP, 12836 indel) (共发现15.5万的变异位点)

4403 were failed by the strand-filter

139153 variant positions reported (126762 SNP, 12391 indel)

502 de novo mutations reported (376 SNP, 126 indel) (真正属于 de novo mutations只有502个)

1734 initially DeNovo were re-called Germline

12 initially DeNovo were re-called MIE

3 initially DeNovo were re-called MultAlleles

522 initially MIE were re-called Germline

1 initially MIE were re-called MultAlleles

3851 initially Untransmitted were re-called Germline然后我看了看输出的文件trio.mpileup.output.snp.vcf

软件是这样解释的 > The output of the trio subcommand is a single VCF in which all variants are classified as germline (transmitted or untransmitted), de novo, or MIE.

FILTER - mendelError if MIE, otherwise PASS

STATUS - 1=untransmitted, 2=transmitted, 3=denovo, 4=MIE

DENOVO - if present, indicates a high-confidence de novo mutation call

里面的信息量还是不清楚。

我首先对拿到的trio.de_novo.mutaion.snp.vcf文件进行简化,只看基因型!

head status.txt (顺序是dad,mom,child)

STATUS=2 0/0 0/1 0/1

STATUS=2 1/1 1/1 1/1

STATUS=2 0/1 0/0 0/1

STATUS=2 1/1 1/1 1/1

STATUS=1 0/1 0/0 0/0

STATUS=1 0/1 0/0 0/0

STATUS=2 1/1 1/1 1/1

STATUS=2 1/1 1/1 1/1

STATUS=2 1/1 1/1 1/1

STATUS=2 0/1 0/1 0/1

#那么总结如下:

26564 STATUS=1 无所以无 (0/0 0/1 0/0或者 0/1 0/0 0/0等等)

97764 STATUS=2 有所以有 (1/1 1/1 1/1 或者0/1 0/1 1/1等等)

385 STATUS=3 无中生有 (0/0 0/0 0/1 或者0/0 0/0 1/1)

1485 STATUS=4 有中生无 (1/1 0/1 0/0 等等)我用annovar注释了一下

/home/jmzeng/bio-soft/annovar/convert2annovar.pl -format vcf4 trio.mpileup.output.snp.vcf > trio.snp.annovar

/home/jmzeng/bio-soft/annovar/annotate_variation.pl -buildver hg19 --geneanno --outfile trio.snp.anno trio.snp.annovar /home/jmzeng/bio-soft/annovar/humandb结果是:

A total of 132268 locus in VCF file passed QC threshold, representing 132809 SNPs (86633 transitions and 46176 transversions) and 3 indels/substitutions可以看到最后被注释到外显子上面的突变有两万多个。

23794 284345 3123333 trio.snp.anno.exonic_variant_function这个应该是非常有意义的,但是我还没学会后面的分析。只能先做到这里了……

6.2.2 转录组

转录组测序的研究对象为特定细胞在某一功能状态下所能转录出来的所有 RNA 的总和,包括 mRNA 和非编码 RNA 。通过转录组测序,能够全面获得物种特定组织或器官的转录本信息,从而进行转录本结构研究、变异研究、基因表达水平研究以及全新转录本发现等研究。

其中,基因表达水平的探究是转录组领域最热门的方向,利用转录组数据来识别转录本和表达定量,是转录组数据的核心作用。由于这个作用,他可以不依赖其他组学信息,单独成为一个产品项目RNA-seq测序。所以很多时候转录组测序会与RNA-seq混为一谈。

现在RNA-seq数据使用广泛,但是没有一套流程可以解决所有的问题。比较值得关注的RNA-seq分析中的重要的步骤包括:实验设计,质控,read比对,表达定量,可视化,差异表达,识别可变剪切,功能注释,融合基因检测,eQTL定位等。

6.2.2.1 RNA-seq表达量分析指引

(1):计算机资源的准备

最好是有mac或者linux系统,8G+的内存,500G的存储即可。 如果你是Windows,那么安装必须安装 git,notepad++,everything,还有虚拟机,在虚拟机里面安装linux,最好是ubuntu。 需要安装的软件包括 sratoolkit,fastqc,hisats,samtools,htseq-count,R,Rstudio 软件安装的代码,在生信技能树公众号后台回复老司机即可拿到。 进阶作业,每个软件都收集一个中文教程链接,并自己阅读,发在论坛里面。

(2):读文章拿到测序数据

本系列课程学习的文章是:AKAP95 regulates splicing through scaffolding RNAs and RNA processing factors. Nat Commun 2016 Nov 8;7:13347. PMID: 27824034 很容易在文章里面找到数据地址GSE81916 这样就可以下载sra文件 作业,看文章里的methods部分,把它用到的软件和参数摘抄下来!

然后理解GEO/SRA数据库的数据存放形式,把规律和笔记发在论坛上面!

(3):了解fastq测序数据

需要用安装好的sratoolkit把sra文件转换为fastq格式的测序文件,并且用fastqc等软件测试测序文件的质量!

作业,理解测序reads,GC含量,质量值,接头,index,fastqc的全部报告,搜索中文教程,并发在论坛上面。

(4):了解参考基因组及基因注释

在UCSC下载hg19参考基因组,我博客有详细说明,从gencode数据库下载基因注释文件,并且用IGV去查看你感兴趣的基因的结构,比如TP53,KRAS,EGFR等等。

作业,截图几个基因的IGV可视化结构!还可以下载ENSEMBL,NCBI的gtf,也导入IGV看看,截图基因结构。了解IGV常识。

(5): 序列比对

比对软件很多,首先大家去收集一下,因为我们是带大家入门,请统一用hisat2,并且搞懂它的用法。

直接去hisat2的主页下载index文件即可,然后把fastq格式的reads比对上去得到sam文件。

接着用samtools把它转为bam文件,并且排序(注意N和P两种排序区别)索引好,载入IGV,再截图几个基因看看!

顺便对bam文件进行简单QC,参考直播我的基因组系列。

(6): reads计数

实现这个功能的软件也很多,还是烦请大家先自己搜索几个教程,入门请统一用htseq-count,对每个样本都会输出一个表达量文件。

需要用脚本合并所有的样本为表达矩阵。参考:生信编程直播第四题:多个同样的行列式文件合并起来

对这个表达矩阵可以自己简单在excel或者R里面摸索,求平均值,方差。 看看一些生物学意义特殊的基因表现如何,比如GAPDH,β-ACTIN等等。 这是一个分水岭,后面的分析主要靠R了,前面的分析都最好是在linux系统下面完成,主要是安装软件,下载数据,运行。

有几个笔记不错的整合作业:

(7): 差异基因分析

这个步骤推荐在R里面做,载入表达矩阵,然后设置好分组信息,统一用DEseq2进行差异分析,当然也可以走走edgeR或者limma的voom流程。

基本任务是得到差异分析结果,进阶任务是比较多个差异分析结果的异同点。

(8): 差异基因结果注释

我们统一选择p<0.05而且abs(logFC)大于一个与众的基因为显著差异表达基因集,对这个基因集用R包做KEGG/GO超几何分布检验分析。

然后把表达矩阵和分组信息分别作出cls和gct文件,导入到GSEA软件分析。 基本任务是完成这个分析。

最后,把同样的代码实践与其它几篇转录组文章,并且把代码和分析结果发在论坛上面;

- http://biotrainee.com/jmzeng/RNA-seq/RNA-seq-example-GSE81916-two-group.sh

- http://biotrainee.com/jmzeng/RNA-seq/DEG.zip

我以前在博客写过的

- http://www.bio-info-trainee.com/2218.html

比如可以来一些实战:

- 生信技能树»生信技能树›互动作业›项目实战›mRNA-seq数据分析实战

- MeDIP-seq,ChIP-seq,RNA-seq结合起来分析

6.2.2.2 RNA-seq检测变异分析实战

前面我们说到RNA-seq最重要的就是对所测样品进行基因表达量的测定,但也有部分课题需要检测RNA-seq试剂里面的变异位点。 这里也进行简单的介绍,如下:

RNA-seq 序列比对

对 RNA-seq 产出的数据进行变异检测分析,与常规重测序的主要区别就在序列比对这一步,因为 RNA-seq 的数据是来自转录本的,比对到参考基因组需要跨越转录剪切位点,所以 RNA-seq 进行变异检测的重点就在于跨剪切位点的精确序列比对

文献 systematic evaluation of spliced alignment programs for RNA-seq data 中对 RNA-seq 数据常用的 11 款比对软件进行了详细测试,包括 STAR 2-pass,而 GATK 对 RNA-seq 数据变异检测的最佳实践流程中选用了 STAR 2-pass 这一方法进行比对,STAR 发表的文章至今已被引用 1900 余次,这款软件的比对速度很快,也是 ENCODE 项目的御用比对软件。

STAR 2-pass 模式需要进行两次序列比对,建立两次参考基因组索引。它的思路是第一次建参考基因组索引之后进行初步的序列比对,根据初步比对结果得到该样本所有的剪切位点信息,包括参考基因组注释 GTF 中已知的剪切位点和比对时新发现的剪切位点,然后利用第一次比对得到的剪切位点信息重新对参考基因组建立索引,然后进行第二次的序列比对,这样可以得到更精确的比对结果。

这里使用了一个测试数据演示流程,第一次对参考基因组建索引:

# star 1-pass index

STAR --runThreadN 8 --runMode genomeGenerate \

--genomeDir ./star_index/ \

--genomeFastaFiles ./genome/chrX.fa \

--sjdbGTFfile ./genes/chrX.gtf然后进行第一次序列比对:

#star 1-pass align

STAR --runThreadN 8 --genomeDir ./star_index/ \

--readFilesIn ./samples/ERR188044_chrX_1.fastq.gz ./samples/ERR188044_chrX_2.fastq.gz \

--readFilesCommand zcat \

--outFileNamePrefix ./star_1pass/ERR188044之后根据第一次比对得到的所有剪切位点,重新对参考基因组建立索引:

# star 2-pass index

STAR --runThreadN 8 --runMode genomeGenerate \

--genomeDir ./star_index_2pass/ \

--genomeFastaFiles ./genome/chrX.fa \

--sjdbFileChrStartEnd ./star_1pass/ERR188044SJ.out.tab再进行 STAR 二次序列比对:

# star 2-pass align

STAR --runThreadN 8 --genomeDir ./star_index_2pass/ \

--readFilesIn ./samples/ERR188044_chrX_1.fastq.gz ./samples/ERR188044_chrX_2.fastq.gz \

--readFilesCommand zcat \

--outFileNamePrefix ./star_2pass/ERR188044由于后面要用 GATK 进行 call 变异,还需要对比对结果 SAM 文件进行一些处理,这些都可以用 picard 来做,包括 SAM 头文件添加 @RG 标签,SAM 文件排序并转 BAM 格式,然后标记 duplicate:

# picard Add read groups, sort, mark duplicates, and create index

java -jar picard.jar AddOrReplaceReadGroups \

I=./star_2pass/ERR188044Aligned.out.sam \

O=./star_2pass/ERR188044_rg_added_sorted.bam \

SO=coordinate \

RGID=ERR188044 \

RGLB=rna \

RGPL=illumina \

RGPU=hiseq \

RGSM=ERR188044

java -jar picard.jar MarkDuplicates \

I=./star_2pass/ERR188044_rg_added_sorted.bam \

O=./star_2pass/ERR188044_dedup.bam \

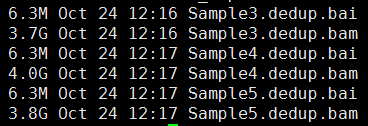

CREATE_INDEX=true \

VALIDATION_STRINGENCY=SILENT \

M=./star_2pass/ERR188044_dedup.metrics到此序列比对就完成了。

使用 GATK 进行变异检测

感觉 GATK 里面的工具都很慢(相对于其他的软件特别慢!),都是单线程在跑,有的虽然可以设置为多线程但是感觉没啥速度上的提升,所以要有点耐心……

由于 STAR 软件使用的 MAPQ 标准与 GATK 不同,而且比对时会有 reads 的片段落到内含子区间,需要进行一步 MAPQ 同步和 reads 剪切,使用 GATK 专为 RNA-seq 应用开发的工具 SplitNCigarReads 进行操作,它会将落在内含子区间的 reads 片段直接切除,并对 MAPQ 进行调整。DNA 测序的重测序应用中也有序列比对软件的 MAPQ 与 GATK 无法直接对接的情况,需要进行调整。

# samtools faidx chrX.fa

# samtools dict chrX.fa

java -jar GenomeAnalysisTK.jar -T SplitNCigarReads \

-R ./genome/chrX.fa \

-I ./star_2pass/ERR188044_dedup.bam \

-o ./star_2pass/ERR188044_dedup_split.bam \

-rf ReassignOneMappingQuality \

-RMQF 255 \

-RMQT 60 \

-U ALLOW_N_CIGAR_READS之后就是可选的 Indel Realignment,对已知的 indel 区域附近的 reads 重新比对,可以稍微提高 indel 检测的真阳性率,如果时间紧张也可以不做,这一步影响很轻微

# 可选步骤 IndelRealign

java -jar GenomeAnalysisTK.jar -T RealignerTargetCreator \

-R ./genome/chrX.fa \

-I ./star_2pass/ERR188044_dedup_split.bam \

-o ./star_2pass/ERR188044_realign_interval.list \

-known Mills_and_1000G_gold_standard.indels.hg19.sites.vcf

java -jar GenomeAnalysisTK.jar -T IndelRealigner \

-R ./genome/chrX.fa \

-I ./star_2pass/ERR188044_dedup_split.bam \

-known Mills_and_1000G_gold_standard.indels.hg19.sites.vcf \

-o ./star_2pass/ERR188044_realign.bam \

-targetIntervals ./star_2pass/ERR188044_realign_interval.list

然后还是可选的 BQSR,这一步操作主要是针对测序质量不太好的数据,进行碱基质量再校准,如果对自己的测序数据质量足够自信可以省略,2500 之后 Hiseq 仪器的数据质量都挺不错的,可以根据 FastQC 结果来决定。这一步省了又能节省时间

# 可选步骤 BQSR

java -jar GenomeAnalysisTK.jar \

-T BaseRecalibrator \

-R ./genome/chrX.fa \

-I ./star_2pass/ERR188044_realign.bam \

-knownSites 1000G_phase1.snps.high_confidence.hg19.sites.vcf \

-knownSites Mills_and_1000G_gold_standard.indels.hg19.sites.vcf \

-o ./star_2pass/ERR188044_recal_data.table

java -jar GenomeAnalysisTK.jar \

-T PrintReads \

-R ./genome/chrX.fa \

-I ./star_2pass/ERR188044_realign.bam \

-BQSR ./star_2pass/ERR188044_recal_data.table \

-o ./star_2pass/ERR188044_BQSR.bam

比如下面的数据就可以放心的省略这两步了:

现在终于可以进行变异检测了,GATK 官网说 HC 表现比 UC 好,所以这里用 HC 进行变异检测:

java -jar GenomeAnalysisTK.jar -T HaplotypeCaller \

-R ./genome/chrX.fa \

-I ./star_2pass/ERR188044_dedup_split.bam \

-dontUseSoftClippedBases \

-stand_call_conf 20.0 \

-o ./star_2pass/ERR188044.vcf

call 完变异之后再进行过滤:

java -jar GenomeAnalysisTK.jar \

-T VariantFiltration \

-R ./genome/chrX.fa \

-V ./star_2pass/ERR188044.vcf \

-window 35 \

-cluster 3 \

-filterName FS -filter "FS > 30.0" \

-filterName QD -filter "QD < 2.0" \

-o ./star_2pass/ERR188044_filtered.vcf然后就拿到变异检测结果了,可以用 ANNOVAR 或 SnpEff 或 VEP 进行注释,根据自己的需要进行筛选了。

6.2.2.3 全转录组

全转录组即包含mRNA,small RNA,lncRNA,circRNA的测序。

搞研究的小伙伴目前大多默认转录组指的是mRNA。而我们知道转录组中也包含着非编码RNA(ncRNA),包括具有调控功能的ncRNAs和管家RNAs(如tRNA,rRNA等)。对转录组中的非编码RNA,目前大家的研究多集中在具有调控功能的small RNA(以miRNA为代表),长链非编码RNA(lncRNA)和环状RNA(circRNA)上,而这几类ncRNA的调控对象都和mRNA有关。因此,全转录组即包含了ncRNAs和mRNA。 大家目前主要关心调控ncRNAs与mRNA的相互作用关系。全转录组的提出,是为了与大家默认的转录组(mRNA)有所区分,并不是一个新概念。但是在实验和数据分析上,两者还是有一些不同的。

全转录组文库构建

全转录组测序是通过构建2个文库,1个小RNA文库(包含miRNA)和一个去除核糖体的链特异性文库(包含mRNA,lncRNA,和circRNA),然后分别上机测序,最后主要获得4类RNA——miRNA,lncRNA,mRNA,circRNA的序列信息。

由于miRNA序列较短(18~26 nt),而其他三类RNA序列较长(通常在1 kb以上),因此它们构建文库的方式会不一样,长序列需要先片段化再建库。这也造成了两者的测序读长是不一样的,小RNA文库的测序读长是SE50,长序列文库的测序读长是PE150,因而需要分别上机测序。 我们熟悉的转录组测序只需要构建一个文库,针对mRNA进行序列鉴定和分析。

全转录组测序的数据分析

不同于只能获取mRNA信息的转录组测序,在全转录组测序完成后,我们可以获取4类主要RNA(miRNA,mRNA,lncRNA,circRNA)的序列信息。接着我们对这4类RNA进行标准分析和整合分析。 标准分析是针对每类RNA主要讨论,序列鉴定,序列特征分析,差异表达分析,和功能富集分析; 整合分析是全转录组测序的重点内容,基于标准分析的结果,整合分析重点讨论非编码RNA与编码RNA间的调控关系,主要包括两者间互作关系miRNA vs mRNA,miRNA vs lncRNA,miRNA vs circRNA,再进一步讨论三者间互作关系mRNA vs miRNA vs lncRNA,mRNA vs miRNA vs circRNA。而三者间的互作关系正是目前讨论得如火如荼的ceRNA(competing endogenous RNA)调控网络。

6.2.2.4 可变剪切

什么是可变剪接,研究可变剪接的意义?

某些基因的一个mRNA前体可以通过选择不同的剪接位点产生不同的可变剪接(Alternative Splicing, AS)形式,这种可变剪接通过以下两种方式参与基因表达调控:

- 1)导致一个基因形成多个剪接异构体(isoform),从而编码不同的蛋白质

- 2)通过无义介导的mRNA降解(NMD)和miRNA调节来调整mRNA的稳定性及翻译。

可变剪接是转录本和蛋白质多样性的主要来源,已有研究表明可变剪接与某些数量性状基因、性别决定通路(如果蝇)、遗传疾病(如脆性X综合征)等密切相关。对可变剪接进行精准的鉴定分析,能够更深入地研究基因表达模型和调控机制。

如何对标准的mRNA-seq数据进行可变剪切分析?

这个数据分析点比较小众,理论上不属于本书的讲解范畴,我们就简单描述部分。可以用ASprofile 软件对 Cufflinks 预测的转录本的可变剪切事件进行分类统计,常见可变剪切事件如下所示:

- AE: Alternative exon ends (5’ , 3’ , or both) —– 可变 5’ 或3’ 端剪切

- XAE: Approximate AE (5’ , 3’ , or both) —– 近似可变 5’ 或3’ 端剪切

- IR: Intron retention —– 单内含子保留

- XIR: Approximate IR —– 近似单内含子保留

- MIR: Multi-IR —– 多内含子保留

- XMIR: Approximate MIR —– 近似多内含子保留

- TSS: Alternative 5’ first exon —– 第一个外显子可变剪切

- TTS: Alternative 3’ last exon —– 最后一个外显子可变剪切

- SKIP: Skipped exon —– 单外显子跨跃

- XSKIP: Approximate SKIP —– 近似单外显子跨跃

- MSKIP: Multi-exon SKIP —– 多外显子跨跃

- XMSKIP: Approximate MSKIP —– 近似多外显子跨跃

可以将Length >= 200bp 且 exon number >=2 作为可靠的新基因的转录本筛选条件,新基因的转录本需要做Nr, KEGG的数据库注释。

至于基因结构优化,对于人、小鼠、拟南芥等模式生物来说,基因注释相对完整,但对于研究没那么透彻的其他物种,我们可以用reads来优化基因结构,从而完善它们的基因注释信息。

Reads比对参考基因组后,我们用Cufflink软件对reads进行转录本重构,将重构结果与参考转录本序列进行比较,重构出来的转录本可能会延长基因注释的5’或3’端,由此实现优化基因结构的目的。

可变剪切事件的可视化

Python软件SpliceGrapher可以将可变剪切模型绘制成图片

SpliceGrapher可以根据测序序列预测可变剪切模型,也可以用已知的基因注释文件生成可变剪切模型。它需要两种输入文件,注释gtf/gff3文件和测序reads与参考基因组比对的sam文件。SpliceGrapher可以预测出多种多样的可变剪切事件,已知的基因模型中存在Alt 3’(可变3’端)、Skipped Exon(跳过外显子)、Intron Retention(内含子保留)、Alt 5’(可变5’端)、既是Alt 3’又是Skipped Exon、既是Alt 5’又是Intron Retention等多种可变剪切事件。不同的事件用不同的颜色标注出来。

发表这个工具的文章是Xiaoxian Liu, et al. Detecting Alternatively Spliced Transcript Isoforms from Single-Molecule Long-Read Sequences without a Reference Genome. Mol Ecol Resour. (2017)

6.2.2.5 融合基因分析

基因融合现象发生在很多致命疾病中,如果是癌症等疾病的融合基因分析可以使用defuse软件, 利用reads的基因跨越以及一对reads的相对距离进行基因融合查找,当然,也可以使用BGI的SOAP系列,生信菜鸟团博客里面有详细描述软件的安装以及示例数据的测试使用。

结题报告能给用户的就是软件找到的可能的融合基因表格,表格里面可能有下面的内容:

6.2.2.6 自学miRNA-seq八讲

第一讲:文献选择与解读

前阵子逛BioStar论坛的时候看到了一个关于miRNA分析的问题,提问者从NCBI的SRA中下载文献提供的原始数据,然后处理的时候出现了问题。我看到他列出的数据来自iron torrent测序仪,而且我以前也没有做过miRNA-seq的数据分析, 就自学了一下。因为我有RNA-seq的基础,所以理解学习起来比较简单。

在这里记录自己的学习过程,希望对需要的朋友有帮助。

这里选择的文章是2014年发表的,作者用ET-1刺激human iPSCs (hiPSC-CMs) 细胞前后,观察miRNA和mRNA表达量的变化,我并没有细看文章的生物学意义,仅仅从数据分析的角度解读一下这篇文章,mRNA表达量用的是Affymetrix Human Genome U133 Plus 2.0 Array,分析起来特别容易。得到表达矩阵,然后用limma这个包找差异表达基因即可。

但是miRNA分析起来就有点麻烦了,作者用的是iron torrent测序仪。不过从SRA数据中心下载的是已经去掉接头的fastq格式测序数据,所以这里其实并不需要考虑测序仪的特异性。

关于该文章的几个资料

- paper : http://journals.plos.org/plosone/article?id=10.1371/journal.pone.0108051

- Aggarwal P, Turner A, Matter A, Kattman SJ et al. RNA expression profiling of human iPSC-derived cardiomyocytes in a cardiac hypertrophy model. PLoS One 2014;9(9):e108051. PMID: 25255322

- The accession numbers are 1. SuperSeries (mRNA+miRNA) - GSE60293

- mRNA expression array - GSE60291 (Affymetrix Human Genome U133 Plus 2.0 Array)

- miRNA-Seq - GSE60292 (Ion Torrent)

- GEO : http://www.ncbi.nlm.nih.gov/geo/query/acc.cgi?acc=GSE60292

- FTP : ftp://ftp-trace.ncbi.nlm.nih.gov/sra/sra-instant/reads/ByStudy/sra/SRP/SRP045/SRP045420

接下来我们要知道文章做了哪些分析,然后才能自己模仿看是否可以得到同样的分析结果。

文章数据处理流程

- Ion Torrent’s Torrent Suite version 3.6 was used for basecalling

- Raw sequencing reads were aligned using the SHRiMP2 aligner and were aligned against the human reference genome (hg19) for novel miRNA prediction and then against a custom reference sequence file containing miRBase v.20 known human miRNA hairpins, tRNA, rRNA, adapter sequences and predicted novel miRNA sequences.(Genome_build: hg19, miRBase v.20 human miRNA hairpins)

- The miRDeep2 package (default parameters) was used to predict novel (as yet undescribed) miRNAs

- Alignments with less than 17 bp matches and a custom 3′ end phred q-score threshold of 17 were filtered out.

- miRNA quanitification was done using HTSeq v0.5.3p3 using the default union parameter. Differential miRNA expression was analyzed using the DESeq (v.1.12.1) R/Bioconductor package

- In this study, differentially expressed genes that had a false discovery rate cutoff at 10% (FDR< = 0.1), a log2 fold change greater than 1.5 and less than −1.5 were considered significant.

- Target gene prediction was performed using the TargetScan (version 6.2) database

- We also used miRTarBase (version 4.3), to identify targets that have been experimentally validated

- miR-Deep2 and miReap predict exact precursor sequence according from mature sequence

文章提到了fastq数据质量控制标准,数据比对工具,比对的参考基因组(两条比对线路),获得miRNA表达量,miRNA预测,miRNA靶基因预测。

这也是我们学习miRNA-seq的数据分析的标准套路, 而且作者给出了所有的分析结果,我们完全可以通过自己的学习来重现他的分析过程。

Supplementary_files_format_and_content: tab-delimited text files containing raw read counts for known mature human miRNAs.(表达矩阵)

We detected 836 known human mature miRNAs in the control-CMs and 769 in the ET1-CMs

Based on our miRNA-Seq data, we predicted 506 sequences to be potentially novel, as yet undescribed miRNAs.

In order to validate the expression profiles of the miRNAs detected, we performed RT-qPCR on a subset of five known human mature and five of our predicted novel miRNAs.

we obtained a total of 1,922 predicted miRNA-mRNA pairs represented by 309 genes and 174 known mature human miRNAs.

当然仅仅是套路分析还不够,所以他进行了 miRNA和mRNA 进行网络分析并做了少量湿实验来验证,最后还扯了一些生物学意义。

第二讲:搜集学习资料

因为我是完全从零开始入门miRNA-seq分析,所以收集的资料比较齐全。

首先看了部分中文资料,了解miRNA测序是怎么回事,该分析什么,然后主要围绕着第一讲文献里的分析步骤来搜索资料。

miRNA定义

我首先找到了miRNA定义:http://nar.oxfordjournals.org/content/34/suppl_1/D135.full

MicroRNAs (miRNAs) are small RNA molecules, which are ∼22 nt sequences that have an important role in the translational regulation and degradation of mRNA by the base’s pairing to the 3′-untranslated regions (3′-UTR) of the mRNAs. The miRNAs are derived from the precursor transcripts of ∼70–120 nt sequences, which fold to form as stem–loop structures, which are thought to be highly conserved in the evolution of genomes. Previous analyses have suggested that ∼1% of all human genes are miRNA genes, which regulate the production of protein for 10% or more of all human coding genes。

选择参考序列

然后我比较纠结的问题是参考序列如何选择,因为miRNA序列很少,把它map到3G大小的人类基因组有点浪费计算资源,正好我的服务器又坏了,不想太麻烦,想用自己的个人电脑搞定这个学习过程。

我看到很多帖子提到的都是用bowtie比对到参考miRNA数据库(miRNA count: 28645 entries) http://www.mirbase.org/ ,从这个数据库,我明白了前体miRNA和成熟的miRNA的区别,前体miRNA长度一般是70–120 碱基,一般是茎环结果,也就是发夹结构,所以叫做hairpin。成熟之后,一般22 个碱基,在miRNA数据库很容易下载到这些数据,目前人类这个物种已知的成熟miRNA共有2588条序列,而前体miRNA共有1881条序列,我下载(下载时间2016年6月 )的代码如下所示:

wget ftp://mirbase.org/pub/mirbase/CURRENT/hairpin.fa.gz ## 28645 reads

wget ftp://mirbase.org/pub/mirbase/CURRENT/mature.fa.zip ## 35828 reads

wget ftp://mirbase.org/pub/mirbase/CURRENT/hairpin.fa.zip

wget ftp://mirbase.org/pub/mirbase/CURRENT/genomes/hsa.gff3 ##

wget ftp://mirbase.org/pub/mirbase/CURRENT/miFam.dat.zip

grep sapiens mature.fa |wc # 2588

grep sapiens hairpin.fa |wc # 1881

## Homo sapiens

perl -alne '{if(/^>/){if(/Homo/){$tmp=1}else{$tmp=0}};next if $tmp!=1;s/U/T/g if !/>/;print }' hairpin.fa >hairpin.human.fa

perl -alne '{if(/^>/){if(/Homo/){$tmp=1}else{$tmp=0}};next if $tmp!=1;s/U/T/g if !/>/;print }' mature.fa >mature.human.fa

# 这里值得一提的是miRBase数据库下载的序列,居然都是用U表示的,也就是说就是miRNA序列,而不是转录成该miRNA的基因序列,而我们测序的都是基因序列。通过这个代码制作的hairpin.human.fa 和 mature.human.fa 就是本次数据分析的参考基因组。

在搜集资料的过程中,我看到了一篇文献讲挖掘1000genomes的数据找到位于miRNA的snp位点

https://genomemedicine.biomedcentral.com/articles/10.1186/gm363

看起来比较新奇,不过跟本次学习过程没有关系,我就是记录一下,有空回来学习学习。

博客讲解如何分析miRNA数据

公司数据分析流程:

http://bioinfo5.ugr.es/miRanalyzer/miRanalyzer_tutorial.html

http://www.partek.com/sites/default/files/Assets/UserGuideMicroRNAPipeline.pdf

http://partek.com/Tutorials/microarray/microRNA/miRNA_tutorial.pdf

http://www.arraystar.com/reviews/microrna-sequencing-data-analysis-guideline/

耶鲁大学

南方基因

miRNA研究整套方案

Biostar 讨论帖子

miRNA-seq数据处理实战指南

直接用一个包搞定

- http://bioconductor.org/packages/release/bioc/html/easyRNASeq.html

github流程:miRNA Analysis Pipeline v0.2.7

miRNA annotation

网页版分析工具

- https://wiki.uio.no/projects/clsi/images/2/2f/HTS_2014_miRNA_analysis_Lifeportal_14_final.pdf

- http://www.training.prace-ri.eu/uploads/tx_pracetmo/NGSdataAnalysisWithChipster.pdf

可视化IGV User Guide

比较特殊的是新的miRNA预测,miRNA靶基因预测,这块软件太多并没有成型的流程和标准。

第三讲:下载公共数据

前面已经讲到了该文章的数据已经上传到NCBI的SRA数据中心,所以直接根据索引号下载,然后用SRAtoolkit转出我们想要的fastq测序数据即可。

下载的数据一般要进行质量控制,可视化展现一下质量如何,然后根据大题测序质量进行简单过滤。所以需要提前安装一些软件来完成这些任务,包括:sratoolkit /fastx_toolkit /fastqc/bowtie2/hg19/miRBase/SHRiMP

下面是我用新服务器下载安装软件的一些代码记录,因为fastx_toolkit /fastqc我已经安装过,就不列代码了

## pre-step: download sratoolkit /fastx_toolkit_0.0.13/fastqc/bowtie2/hg19/miRBase/SHRiMP

## http://www.ncbi.nlm.nih.gov/Traces/sra/sra.cgi?view=software

## http://www.ncbi.nlm.nih.gov/books/NBK158900/

## 我这里特意挑选的二进制版本程序下载的,这样直接解压就可以用,但是需要挑选适合自己的操作系统的程序。

cd ~/biosoft

mkdir sratoolkit && cd sratoolkit

wget http://ftp-trace.ncbi.nlm.nih.gov/sra/sdk/2.6.3/sratoolkit.2.6.3-centos_linux64.tar.gz

##

## Length: 63453761 (61M) [application/x-gzip]

## Saving to: "sratoolkit.2.6.3-centos_linux64.tar.gz"

tar zxvf sratoolkit.2.6.3-centos_linux64.tar.gz

cd ~/biosoft

mkdir bowtie && cd bowtie

wget https://sourceforge.net/projects/bowtie-bio/files/bowtie2/2.2.9/bowtie2-2.2.9-linux-x86_64.zip/download

#Length: 27073243 (26M) [application/octet-stream]

#Saving to: "download"

mv download bowtie2-2.2.9-linux-x86_64.zip

unzip bowtie2-2.2.9-linux-x86_64.zip

## http://compbio.cs.toronto.edu/shrimp/

mkdir SHRiMP && cd SHRiMP

wget http://compbio.cs.toronto.edu/shrimp/releases/SHRiMP_2_2_3.lx26.x86_64.tar.gz

tar zxvf SHRiMP_2_2_3.lx26.x86_64.tar.gz

cd SHRiMP_2_2_3

export SHRIMP_FOLDER=$PWD ## 这个软件使用的时候比较奇葩,需要设置到环境变量,不能简单的调用全路径SHRiMP这个软件比较小众,我也是第一次听说过。

本来我计划是能用bowtie搞定,但是第一次比对出了一个bug,就是下载的miRNA序列里面的U没有转换成T,所以导致比对率非常之低。于是我不得不根据文章里面记录的软件SHRiMP 来做比对,最后发现比对率完全没有改善,搞得我都在怀疑是不是作者乱来了。

下面是下载数据,质量控制的代码,希望大家可以照着运行一下。

## step1 : download raw data

mkdir miRNA_test && cd miRNA_test

echo {14..19} |sed 's/ /\n/g' |while read id; \

do wget "ftp://ftp-trace.ncbi.nlm.nih.gov/sra/sra-instant/reads/ByStudy/sra/SRP/SRP045/SRP045420/SRR15427$id/SRR15427$id.sra" ;\

done

## step2 : change sra data to fastq files.

## 主要是用shell脚本来批量下载

ls *sra |while read id; do ~/biosoft/sratoolkit/sratoolkit.2.6.3-centos_linux64/bin/fastq-dump $id;done

rm *sra

## 33M --> 247M

#Read 1866654 spots for SRR1542714.sra

#Written 1866654 spots for SRR1542714.sra

## step3 : download the results from paper

## http://www.bio-info-trainee.com/1571.html

## ftp://ftp.ncbi.nlm.nih.gov/geo/series/GSE1nnn/GSE1009/suppl/GSE1009_RAW.tar

mkdir paper_results && cd paper_results

wget ftp://ftp.ncbi.nlm.nih.gov/geo/series/GSE60nnn/GSE60292/suppl/GSE60292_RAW.tar

## tar xvf GSE60292_RAW.tar

ls *gz |while read id ; do (echo $id;zcat $id | cut -f 2 |perl -alne '{$t+=$_;}END{print $t}');done

ls *gz |xargs gunzip

## step4 : quality assessment

ls *fastq | while read id ; do ~/biosoft/fastqc/FastQC/fastqc $id;done

## Sequence length 8-109

## %GC 52

## Adapter Content passed

## write a script : :: cat >filter.sh

ls *fastq |while read id

do

echo $id

~/biosoft/fastx_toolkit_0.0.13/bin/fastq_quality_filter -v -q 20 -p 80 -Q33 -i $id -o tmp ;

~/biosoft/fastx_toolkit_0.0.13/bin/fastx_trimmer -v -f 1 -l 27 -i tmp -Q33 -z -o ${id%%.*}_clean.fq.gz ;

done

rm tmp

## discarded 12%~~49%%

ls *_clean.fq.gz | while read id ; do ~/biosoft/fastqc/FastQC/fastqc $id;done

mkdir QC_results

mv *zip *html QC_results这个代码是我自己根据文章的理解写出的,因为我本身不擅长miRNA数据分析,所以在进行QC的时候参数选择可能并不是那么友好.

~/biosoft/fastx_toolkit_0.0.13/bin/fastq_quality_filter -v -q 20 -p 80 -Q33 -i $id -o tmp ;

~/biosoft/fastx_toolkit_0.0.13/bin/fastx_trimmer -v -f 1 -l 27 -i tmp -Q33 -z -o ${id%%.*}_clean.fq.gz ;最后得到的clean.fq.gz系列文件,就是我需要进行比对的序列。

第四讲:测序数据比对

序列比对是大多数类型数据分析的核心,如果要利用好测序数据,比对细节非常重要,我这里只是研读一篇文章也就没有对比对细节过多考虑,只是列出自己的代码和自己的几点思考,力求重现文章作者的分析结果。

对miRNA-seq数据有两条比对策略:

下载miRBase数据库里面的已知miRNA序列来进行比对

直接比对到参考基因组(比如人类的是hg19/hg38)

前面的比对非常简单,而且很容易就可以数出已经的所以miRNA序列的表达量;后面的比对有点耗时,而且算表达量的时候也不是很方便,但是它的优点是可以来预测新的miRNA,所以大多数文章都会把这两条路给走一下。

本文选择的是SHRiMP这个小众软件,起初我并没有在意,就用的bowtie2而已,参考基因组就用了miRBase数据库下载的人类的参考序列。

## step5 : alignment to miRBase v21 (hairpin.human.fa/mature.human.fa )

#### step5.1 using bowtie2 to do alignment

mkdir bowtie2_index && cd bowtie2_index

~/biosoft/bowtie/bowtie2-2.2.9/bowtie2-build ../hairpin.human.fa hairpin_human

~/biosoft/bowtie/bowtie2-2.2.9/bowtie2-build ../mature.human.fa mature_human

ls *_clean.fq.gz | while read id ; do ~/biosoft/bowtie/bowtie2-2.2.9/bowtie2 -x miRBase/bowtie2_index/hairpin_human -U $id -S ${id%%.*}.hairpin.sam ; done

## overall alignment rate: 10.20% / 5.71%/ 10.18%/ 4.36% / 10.02% / 4.95% (before convert U to T )

## overall alignment rate: 51.77% / 70.38%/51.45% /61.14%/ 52.20% / 65.85% (after convert U to T )

ls *_clean.fq.gz | while read id ; do ~/biosoft/bowtie/bowtie2-2.2.9/bowtie2 -x miRBase/bowtie2_index/mature_human -U $id -S ${id%%.*}.mature.sam ; done

## overall alignment rate: 6.67% / 3.78% / 6.70% / 2.80%/ 6.55% / 3.23% (before convert U to T )

## overall alignment rate: 34.94% / 46.16%/ 35.00%/ 38.50% / 35.46% /42.41%(after convert U to T )

#### step5.2 using SHRiMP to do alignment

## http://compbio.cs.toronto.edu/shrimp/README

## 3.5 Mapping cDNA reads against a miRNA database

cd ~/biosoft/SHRiMP/SHRiMP_2_2_3

export SHRIMP_FOLDER=$PWD

cd -

## We project the database with:

$SHRIMP_FOLDER/utils/project-db.py --seed 00111111001111111100,00111111110011111100,00111111111100111100,00111111111111001100,00111111111111110000 \

--h-flag --shrimp-mode ls miRBase/hairpin.human.fa

##

$SHRIMP_FOLDER/bin/gmapper-ls -L hairpin.human-ls SRR1542716.fastq --qv-offset 33 \

-o 1 -H -E -a -1 -q -30 -g -30 --qv-offset 33 --strata -N 8 >map.out 2>map.log大家可以看到我们把测序reads比对到前体miRNA和成熟的miRNA结果是有略微区别的,因为一个前体miRNA可以形成多个成熟的miRNA,而并不是所有的成熟的miRNA形式都被记录在数据库,所以一般推荐比对到前体miRNA数据库,这样还可以预测新的成熟miRNA,也是非常有意义的。

另外非常重要的一点是,把U变成T前后比对率差异非常大,这其实是一个非常蠢的错误,我就不多说了。但是做到这一步,其实可以跟文章来做验证,文章有提到比对率,比对的序列。

我也是在博客里面看到这个信息的:

Thank you so much!. Yes I contacted the lab-guy and he just said that trimmed the first 4 bp and last 4bp. ( as you found) So I firstly trimmed the adapter sequences(TGGAATTCTCGGGTGCCAAGGAACTCCAGTCAC) And then, trimmed the first 4bp and last 4bp from reads, which leads to the 22bp peak of read-length distribution(instead of 24bp) Anyhow, I tried to map with bowtie2 again.

> bowtie2 --local -N 1 -L 16

> -x ../miRNA_reference/hairpin_UtoT.fa

> -U first4bptrimmed_A1-SmallRNA_S1_L001_R1_001_Illuminaadpatertrim.fastq

> -S f4_trimmed.samI also changed hairpin.fa file (U to T) Oh.. thank you David, Finallly, I got

> 2565353 reads; of these:

> 2565353 (100.00%) were unpaired; of these:

> 479292 (18.68%) aligned 0 times

> 11959 (0.47%) aligned exactly 1 time

> 2074102 (80.85%) aligned >1 times

> 81.32% overall alignment rate第五讲:获取miRNA表达量

得到比对后的sam/bam文件只能算是level2的数据,一般我们给他人share的结果也是直接给表达矩阵的, miRNA分析跟mRNA分析类似,但是它的表达矩阵更好获取一点。

如果是mRNA,我们一般会跟基因组来比较,而基因组就是24条参考染色体,想知道具体比对到了哪个基因,需要根据基因组注释文件来写程序提取表达量信息,现在比较流行的是htseq这个软件,我前面也写过教程如何安装和使用,这里就不啰嗦了。但是对于miRNA,因为我比对的就是那1881条前体miRNA序列,所以直接分析比对的sam/bam文件就可以知道每条参考miRNA序列的表达量了。

## step6: counts the reads which mapping to each miRNA reference.

## we need to exclude unmapped as well as multiple-mapped reads

## XS:i:<n> Alignment score for second-best alignment. Can be negative. Can be greater than 0 in --local mode

## NM:i:1 ## NM i Edit distance to the reference, including ambiguous bases but excluding clipping

#The following command exclude unmapped (-F 4) as well as multiple-mapped (grep -v “XS:”) reads

#samtools view -F 4 input.bam | grep -v "XS:" | wc -l

## 180466//1520320

##cat >count.hairpin.sh

ls *hairpin.sam | while read id

do

samtools view -SF 4 $id |perl -alne '{$h{$F[2]}++}END{print "$_\t$h{$_}" foreach sort keys %h }' > ${id%%_*}.hairpin.counts

done

## bash count.hairpin.sh

##cat >count.mature.sh

ls *mature.sam | while read id

do

samtools view -SF 4 $id |perl -alne '{$h{$F[2]}++}END{print "$_\t$h{$_}" foreach sort keys %h }' > ${id%%_*}.mature.counts

done

## bash count.mature.sh上面的代码,是我自己写的脚本来算表达量,非常简单,因为我没有考虑细节,直接想得到各个样本测序数据的表达量而已。如果是比对到了参考基因组,就要根据miRNA的gff注释文件用htseq等软件来计算表达量。

得到了表达量,就可以跟文献来做比较

### step7: compare the results with paper's

GSM1470353: control-CM, experiment1; Homo sapiens; miRNA-Seq SRR1542714

GSM1470354: ET1-CM, experiment1; Homo sapiens; miRNA-Seq SRR1542715

GSM1470355: control-CM, experiment2; Homo sapiens; miRNA-SeqSRR1542716

GSM1470356: ET1-CM, experiment2; Homo sapiens; miRNA-Seq SRR1542717

GSM1470357: control-CM, experiment3; Homo sapiens; miRNA-Seq SRR1542718

GSM1470358: ET1-CM, experiment3; Homo sapiens; miRNA-Seq SRR1542719

### 下面我用R语言来检验一下,我得到的分析结果跟文章发表的结果的区别。

a=read.table("bowtie_bam/SRR1542714.mature.counts")

b=read.table("paper_results/GSM1470353_iPS_010313_Unstim_known_miRNA_counts.txt")

plot(log(tmp[,2]),log(tmp[,3]))

cor(tmp[,2],tmp[,3])

##[1] 0.8413439相关性还不错,总算没有分析错。

这个代码是我自己根据文章的理解写出的,因为我本身不擅长miRNA数据分析,所以在进行alignment的时候参数选择可能并不是那么友好。

第六讲:miRNA表达量差异分析

这一讲是miRNA-seq数据分析的分水岭,前面的5讲说的是读文献下载数据比对,然后计算表达量,属于常规的流程分析,一般在公司测序之后都可以拿到分析结果,或者文献也会给出下载结果。

但是单纯的分析一个样本意义不大,一般来说,我们做研究都是针对于不同状态下的miRNA表达量差异分析,然后做注释,功能分析,网络分析,这才是重点和难点。

我这里就直接拿文献处理好的miRNA表达量来展示如何做下游分析,首先就是差异分析。

根据文献,我们可以知道样本的分类情况是

GSM1470353: control-CM, experiment1; Homo sapiens; miRNA-Seq SRR1542714

GSM1470354: ET1-CM, experiment1; Homo sapiens; miRNA-Seq SRR1542715

GSM1470355: control-CM, experiment2; Homo sapiens; miRNA-SeqSRR1542716

GSM1470356: ET1-CM, experiment2; Homo sapiens; miRNA-Seq SRR1542717

GSM1470357: control-CM, experiment3; Homo sapiens; miRNA-Seq SRR1542718

GSM1470358: ET1-CM, experiment3; Homo sapiens; miRNA-Seq SRR1542719

可以看到是6个样本的测序数据,分成两组,就是ET1刺激了CM细胞系前后对比而已!

同时,我们也拿到了这6个样本的表达矩阵,计量单位是counts的reads数,所以我们一般会选用DESeq2,edgeR这样的常用包来做差异分析,当然,做差异分析的工具还有十几个,我这里只是拿一根最顺手的举例子,就是DESeq2。

下面的代码有点长,因为我在bioconductor系列教程里面多次提到了DESeq2使用方法,这里就只贴出代码,反正我要说的重点是,我们通过差异分析得到了差异miRNA列表

### step8: differential expression analysis by R package for miRNA expression patterns:

## 文章里面提到的结果是:

MicroRNA sequencing revealed over 250 known and 34 predicted novel miRNAs to be differentially expressed between ET-1 stimulated and unstimulated control hiPSC-CMs.